Google lo ha vuelto a hacer: se abren las puertas al modo retrato en vídeo

Hasta el lanzamiento del Google Pixel 2 XL, creíamos que la doble cámara era necesaria para el modo retrato. Así nos lo hizo creer Apple, con el argumento de que era obligatorio usar un segundo sensor para captar profundidad. Sin embargo, Google demostró lo contrario, y puso sobre la mesa sus algoritmos de Machine Learning.

Gracias a estos, el Pixel es capaz de dividir fondo y figura sin necesidad de una doble cámara, y por cierto, lo hace de una mejor forma que el resto de sus rivales. Más allá de conformarse con aplicar este software a la fotografía, están trabajando en hacerlo con el vídeo. Evidentemente, esto va mucho más allá del modo retrato, pero la puerta ya está abierta, y puede que el Pixel 3 de la sorpresa este 2018.

Segmentación a tiempo real en vídeo, lo nuevo de Google

El Google Pixel 2 es capaz de crear una máscara para el fondo mediante una matriz de subpíxeles del sensor encargados de recoger dicha información. Lo mejor de todo, es que es capaz de hacerlo tanto con la cámara delantera como con la trasera, por lo que no necesita sensores True Depth como el iPhone X, que por cierto, hace un espantoso recorte en las fotos selfie.

El iPhone X se vale de los sensores de reconocimiento facial para el modo retrato. Google lo hace con la cámara frontal y los mismos algoritmos de la cámara trasera. Los resultados hablan por sí solos

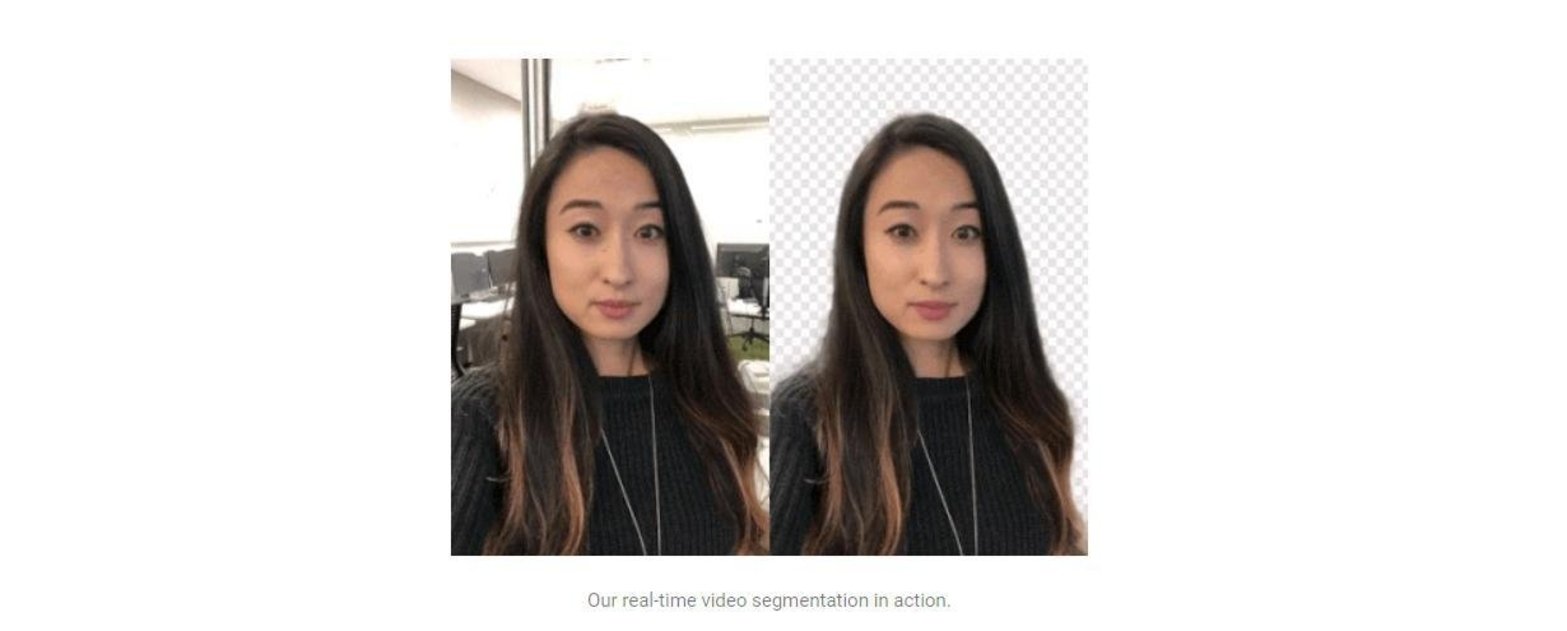

En este caso, Google ha logrado mediante Machine Learning separar fondo y figura a tiempo real y en vídeo, algo que no habíamos visto hasta ahora. Esta tecnología se estrenará en las stories de YouTube, que te permitirán aplicar filtros y fondos que irán cambiando de forma dinámica, como puedes ver en el propio blog de Google

Es sencillamente increíble poder aplicar una máscara que separa fondo y figura en tiempo real, y más sabiendo lo que esto puede suponer en un futuro. Pero... ¿Cómo consigue Google lograr tal proeza?

Así es cómo Google separa figura y fondo

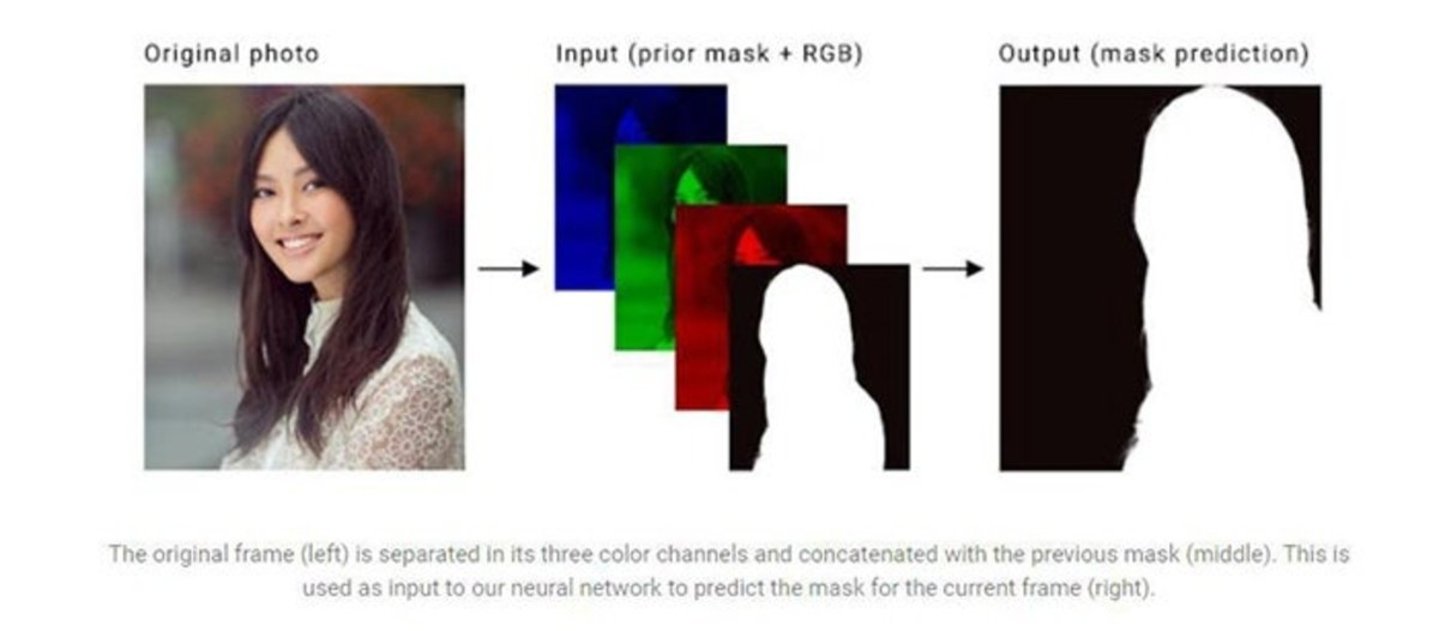

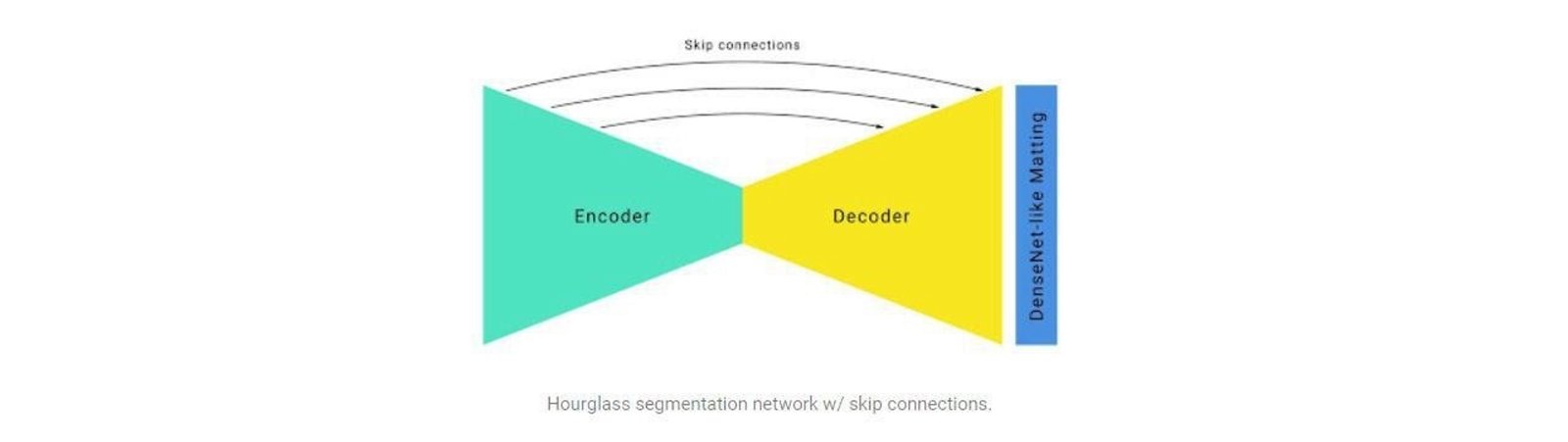

Google utiliza el Machine Learning para resolver una tarea de segmentación, utilizando redes neuronales. ¿En qué consiste dicha tarea? En calcular la máscara binaria que separa el primer plano del fondo para cada fotograma de entrada. En español, la tarea resuelve la distinción entre figura y fondo. La clave está, según Google, en lograr coherencia temporal entre las máscaras -son necesarias una por cada canal del RGB, rojo, verde y azul-.

El modo retrato tradicional, utiliza un segundo sensor que capta información sobre la profundidad. Google logra hacerlo con un solo sensor, trabajando con varias máscaras que permiten distinguir la figura y el fondo de una forma más precisa, al cuidar mediante machine learning el recorte del objeto principal

Para enviar los datos con alta calidad y que el procesado pueda ser de nivel, Google anotó diez de entre miles de imágenes, que lograron capturar un amplio espectro de posiciones en primer plano y configuraciones de fondo. Con estas imágenes, se establecieron 9 categorías o etiquetas. Estos elementos son los que identifica el teléfono para, posteriormente, crear la máscara fondo-figura.

Evidentemente, no basta con recoger los elementos del rostro, hay que lograr separar cada entrada de imagen -los canales RGB anteriormente comentados-, además de una cuarta máscara que ha añadido Google, para usarla como entrada en la red neural.

Para entrenar a la IA, necesitaron seguir "jugando con las máscaras", y es que es necesario bastante trabajo para lograr que todo este proceso se realice a tiempo real.

- Primero, una máscara vacía entrena a la red, esto permite distinguir los objetos de la escena

- Posteriormente, una serie de transformaciones menores siguen entrenando a la red neural, hasta que esta es capaz de descartar objetos o fragmentos inadecuados -Apple no hace esto, por eso es incapaz de eliminar fragmentos de pelo, orejas etc, que sobran en la imagen-

- Por último, mediante una capa ligera de la imagen original, emulan los movimientos rápidos de la cámara y las rotacionesProcedimiento de entrenamiento

Sí, el proceso es extremadamente complejo, y va un poco más allá de lo que hace Google en el asunto de las fotografías, pero estamos ante toda una revolución tecnológica, que abre las puertas a funciones como el modo retrato en vídeo.

Para que este sea posible, es necesario todavía bastante más tiempo, ya que hay que entrenar a la IA para que detecte movimientos bruscos y extremadamente rápidos, ya no sería nada fácil seguirnos el ritmo en un vídeo con mucho movimiento. Sin embargo, Google ha sido la primera en utilizar la fotografía computacional, y ahora repite con el tema del vídeo.

Con el vídeo segmentado en tiempo real, se abren las puertas al modo retrato en vídeo. Todavía hace falta mucho trabajo por delante, ya que esto es más complejo aún, pero Google está demostrando que es algo posible

La gran G, es el claro ejemplo de que el futuro de la fotografía y el vídeo móvil pasan por el software, y que no son necesarias aperturas mecánicas, dobles cámaras -o triples-, ni extravagancias en los sensores. El trabajo de Google con las cámaras está siendo espectacular, y nos morimos de ganas de ver cómo puede avanzar esto en un futuro.

Como te dijimos, en un principio, YouTube será el conejillo de indias para estas pruebas, pero quién sabe si acabaremos viendo esta tecnología en aplicaciones como Instagram -donde ya funciona el Visual Core de Google-, o en el propio modo retrato mientras grabamos un vídeo.

Para estar siempre al día con lo último en tecnología, suscríbete a nuestro canal oficial y verificado de Andro4all en WhatsApp.