Google reina en la fotografía: historia, funcionamiento y curiosidades sobre sus cámaras

Independientemente de que su procesado nos parezca más o menos realista, no hay duda alguna de que Google está haciendo con la fotografía computacional algo increíble. Aquel Google Pixel 1 que se presentó en octubre de 2016 fue la carta de presentación de la compañía con sede en Mountain View, y el inicio de todo un proyecto en constante avance.

Hoy, toca hablar con detenimiento del cuándo y cómo empezó este proyecto, así como del comportamiento del mismo en el Google Pixel 3, modelo recién presentado y portador de grandes novedades de las que Google no había contado sus detalles. Detrás de la posiblemente mejor cámara jamás montada en un smartphone se esconde una tecnología que debes conocer, y que abre las puertas a que el resto de fabricantes mejoren sus resultados.

La cara detrás de los resultados

Nacido en 1953 en Estados Unidos, Marc Levoy es la cabeza pensante del equipo fotográfico en Google. Dejó su trabajo como Profesor Emérito e investigador en el campo de las ciencias computacionales y la ingeniería electrónica en la Universidad de Stanford para liderar el equipo de Google.

El empeño de Levoy para con la cámara era que esta fuese, desde un principio, lo más similar posible a una DSLR. El planteamiento es sencillo, ¿qué haría una réflex en determinada situación? En respuesta a esta pregunta se desarrollan los algoritmos pertinentes.

Fue el encargado, entre otras cosas, de gran parte del funcionamiento de las Google Glass, así como uno de los padres del HDR+. Levoy cuenta con publicaciones de renombre como Light Field Rendering, o grandes explicaciones del funcionamiento de una DSRL en el blog de Google y gracias a él la fotografía computacional de Google avanza a pasos agigantados.

Sus libros han sido citados en más de 42.000 ocasiones por la comunidad científica, y es que Levoy es toda una eminencia en el campo del proceso de volúmenes, Machine Learning y fotografía computacional.

Empezamos por el principio, ¿por qué solo una cámara?

Como bien sabrás, la mayoría de terminales de gama alta cuentan con dos, incluso con tres cámaras. Apple nos hizo creer que eran necesarias dos cámaras para el modo retrato, y los fabricantes Android empezaron a inspirarse en la firma de Cupertino, cayendo en este mismo error. Sin embargo, Google demostró con el Pixel 2 y 2 XL que no era necesaria una segunda cámara para lograr fotografías de retrato sobresaliente, llegando a sobrepasar por mucho a su más directo rival del año pasado, el iPhone X.

En unas palabras para 9to5Google, Google desveló lo que ya sabíamos. No consideran necesaria la doble cámara siempre y cuando se haga un buen trabajo con el software, algo que llevan demostrando desde hace dos generaciones.

Descubrimos que era innecesario. Los teléfonos Pixel extraen suficiente información de profundidad gracias a la tecnología Dual Pixel, para posteriormente ejecutar algoritmos de aprendizaje automático, entrenados en más de un millón de fotos, para producir el efecto de foto deseado. Mario Queiroz, Vicepresidente de Product Managing en Google.

El planteamiento de Google es simple, el procesado pesa más en el resultado final que el sensor. No les falta razón, no les sobra razón. Sin un buen procesado no importa cuantos sensores tengas, aunque estos siempre ayudarán a realizar una mejor fotografía. Los Google Pixel carecen de un zoom óptico real, y el modo retrato tiene sus limitaciones -de las que te hablaremos más adelante-. Sin embargo, actualmente el mejor algoritmo de procesado viene de la mano de Google, y esto es innegable.

¿Desde cuándo Google ofrece tan buenos resultados?

Todo comienza en el año 2015 con los Google Nexus 5X y Nexus 6P. Estos teléfonos supusieron un antes y un después en la fotografía móvil, por el uso del HDR+. Esta tecnología ya estaba presente en el Google Nexus 5 en el año 2013, pero no era más que un proyecto inicial de Google que solo dejaba incertidumbre. Con el Huawei Nexus 6P empezamos a ver esas fotografías contrastadas y con un gran rango dinámico, resultados que encajaron por mérito de Google y por demérito de los demás fabricantes -algo de lo que también hablaremos a continuación-.

El HDR+ lleva presente en Google desde el año 2013, siendo el Nexus 5 el primer terminal del mercado en incorporar esta tecnología. 5 años después, firmas como Apple emulan la tecnología de móvil, con distinta nomenclatura, pero idéntico funcionamiento.

Después de los Nexus llegaron los Pixel, y el primer modelo o OG Pixel fue considerado como móvil con mejor cámara del mercado por la mayoría de medios tecnológicos. De ahí en adelante, el procesado de estos teléfonos se convirtió en el rival a batir, y en algo que ni siquiera terminales de 2018 han logrado superar.

¿Qué problema hay con el resto de fabricantes?

El procesado, ya que todo depende del mismo. Actualmente encontramos auténticas maravillas en el apartado fotográfico de la mano de Samsung o Huawei, pero el procesado hace que sus fotografías sigan por detrás. Es cierto que encontramos mejores fotos nocturnas en el caso de Huawei, controles manuales, algunos modos extra... pero a la hora de realizar una evaluación global, Google vuelve a estar a la cabeza.

La fotografía es luz, y este es el principal problema que tienen los fabricantes. Apple ha necesitado 5 años para implementar el HDR+ de Google, bajo el nombre de Smart HDR. Hasta entonces, el control de las altas luces ha sido un auténtico desastre, dejando fotografías quemadas tanto de día como de noche.

Por mucho que la cámara del iPhone XS mejore a la del X, es incomprensible que un año después de lanzar el “iPhone del futuro” a 1159€, haga esto con las luces.https://t.co/TassexAu9T pic.twitter.com/koepdHqgIW

— Antonio Sabán (@Ansamor) 18 de septiembre de 2018

En el caso de Huawei y Samsung, obtenemos los mismos resultados. Fotografías de primera categoría, ensombrecidas -irónicamente- por un exceso de luces altas. El principal problema con esto es que cuando un terminal nos ofrece una fotografía algo oscura, esa información es recuperable, pero cuando está quemada por completo, perdemos por completo la información, no podemos arreglar la fotografía.

Actualmente, tan solo Google y Apple controlan las altas luces gracias al HDR+ y el Smart HDR, el resto de fabricantes, independientemente del resto de bondades que aporten respeto a los dos grandes OEM citados, son incapaces de realizar fotografías con un rango dinámico controlado, y esto puede llegar a resultar grave si le exigimos lo que se debe a terminales de 1.000 euros.

Note 9 VS Pixel 2 XL pic.twitter.com/pr1S5Uo6Zt

— Carlos Santa Engracia (@csantaengracia) 22 de agosto de 2018

En definitiva, el HDR va mucho más allá de un efecto visual. Es la única forma que tienen los smartphone de evitar los quemados, y la gama alta no puede permitirse información perdida por un mal control de las altas luces. Visto que Google y Apple han apostado por este camino, queda esperar que el resto de fabricantes admita que este es el sendero correcto.

¿Cuáles son las características del procesado de Google?

Antes de entrar en tecnicismos y en explicar las funciones exclusivas de los Pixel, toca hablar de cómo Google interpreta la fotografía móvil. Como bien sabrás, cuando realizamos una fotografía en modo JPEG, el teléfono procesa la imagen y asigna ciertos valores de saturación, contraste, nitidez... De lo contrario, obtendríamos un archivo RAW sin procesado alguno, que tendríamos que revelar.

Google considera que las fotografías tienen que tener contraste y nitidez, muchísima nitidez. El resto de fabricantes aplica un procesado más enfocado a la naturalidad y la reducción del ruido. Esto nos puede beneficiar en algunas situaciones, pero en la mayoría de las ocasiones y sobre todo, cuando hablamos de fotografía de personas, acabamos con fotografías emplastadas y faltas de detalle.

Selfie iPhone XS vs Pixel 2 - Sin retoques

— Jose (@josejacas) 10 de octubre de 2018

¿Prefieres algo más realista o más efectista? pic.twitter.com/GNVUkF7Su0

Si bien técnicamente hablando las fotografías correctas serían aquellas con menos procesado, no hay duda de que los resultados de Google llaman más la atención. Vista la forma y concepto que tiene Google para con su procesado, toca hablar de cómo funciona este realmente, cuáles son sus principales ventajas, y cuáles son sus principales inconvenientes.

¿Cómo procesa Google sus fotografías?

El primer reto al que se enfrenta cualquier fabricante a la hora de trabajar en su cámara es el tamaño del sensor. El sensor principal cuenta con 12,2 megapíxeles, con tecnología Dual Pixel. Esto significa que cada uno de sus píxeles divide la luz hacia derecha e izquierda, por lo que realmente contamos con un total de 24 megasubpíxeles. En el caso de los Pixel 3, la óptica está compuesta de 6 lentes y un estabilizador óptico, que permite eliminar cualquier tipo de microtrepidación que sufra la cámara.

Como decíamos, la clave de la fotografía en Google está en su procesado. Cuando realizamos una fotografía, suceden una serie de entre 30 y 40 eventos, que dan como resultado las imágenes que todos conocemos.

- Cuando la fotografía sale del sensor, está cruda, por lo que es necesario cocinarla. Procesarla en este caso

- Gracias a las matrices de las que está compuesto el sensor, el terminal es capaz de captar los colores de forma individual en el espectro RGB -rojo, verde y azul-.

- Al combinar estos colores primarios, somos capaces de obtener una imagen a color. Este proceso tiene como nombre interpolación cromática.

- Una vez interpretado el color, el Pixel tiene que procesar los colores en sí, el balance de blancos, el ruido... En este caso, hablamos de algoritmos que optimizan el procesamiento de las imágenes, gracias a una IA que ha sido entrenada para aplicar una u otra configuración en base a la escena que estamos fotografiando

- A la hora de aplicar el HDR+, Google nos cuenta que buscaba lograr con un sensor pequeño los resultados de uno grande. Mediante la interpolación de varias fotografías con distintas exposiciones, Google logra una imagen final perfectamente expuesta.

Pero la magia del Google Pixel no recae únicamente en el procesado de imágenes normales, sino en cómo logra crear un mapa de profundidad para utilizar el modo retrato. Si bien carece de progresión en el enfoque y el resultado puede pecar de artificial, el modo retrato del Google Pixel es el más impactante de la actualidad, y así es cómo se logra.

En primer lugar, el terminal toma la fotografía de forma normal, aplicando el procesado comentado anteriormente. Posteriormente, el Pixel crea un recorte del sujeto desde el fondo, algo de lo que es capaz gracias al trabajo de una IA que ha sido entrenada para distinguir fondo y figura para aplicar el recorte.

Ante dicho recorte, nos encontramos con una nueva capa, una máscara de recorte que ha logrado separar el fondo de la figura, aunque en este punto no tenemos información sobre la profundidad de la escena, con esta imagen lo entenderás.

Imágenes obtenidas de Alessandro Michelazzi

Gracias al Dual Pixel que, como te dijimos, era capaz de dividir los píxeles del sensor para calcular las diferencias de luz entre uno y otro lado de la lente, el terminal es capaz de obtener información sobre la profundidad de campo, siempre y cuando combine la información obtenida mediante el Dual Pixel con la máscara de recorte. Este es el único secreto que guarda Google, y es que no arroja datos exactos sobre cómo combina las distintas máscaras que componen sus fotografías. El resumen serían cuatro pasos: captura de imagen, separación de fondo y figura mediante segmentación semántica de imagen, obtención de información sobre la profundidad de campo y combinado de las imágenes.

Una vez realizada la fotografía, como hemos obtenido por un lado la imagen normal y por otro la del modo retrato, el teléfono almacena ambas fotografías a máxima calidad, de los formatos hablaremos posteriormente, ya que con el Pixel 3 y Pixel 3 XL llegan ciertas novedades que merecen comentario aparte.

Segmentación semántica de imagen, una tecnología que merece unas palabras

Gracias al Machine Learning, el Google Pixel es capaz de detectar partes de la figura categorizadas en ciertas etiquetas o palabras -labios, pelo, gafas, ojos-... En total hablamos de 9 categorías, que son de las que se valdrá la IA a la hora de aplicar el recorte que llevará a la máscara. Este, es uno de los puntos diferenciales de la cámara de Google, y que abre las puertas al modo retrato en vídeo, ya que han conseguido hacer que esta segmentación de imagen funcione a tiempo real.

¿Y el zoom? ¿Es que nadie piensa en el zoom?

A la izquierda, imagen original ampliada. A la derecha, imagen ampliada y mejorada con RAISR.

Si bien es una característica, en mi opinión como fotógrafo, marginal en un teléfono, el no contar con una doble cámara pudiera perjudicar al Pixel a la hora de hacer zoom. RAISR, o Rapid and Accurate Image Super Resolution, fue presentado en noviembre de 2016 por Google, aunque no se incorporó hasta la llegada del Google Pixel 2.

I've tried to capture just how good the Pixel 3's Super Res Zoom is with this comparison: left is iPhone XS telephoto camera and right is Pixel 3 digital zoom, matched for focal length.

— Daniel Bader (@journeydan) 10 de octubre de 2018

It's not perfect (the iPhone is definitely sharper) but it's pretty damn good. pic.twitter.com/J9JFiegtVf

Esta tecnología permite que, mediante un sistema de aprendizaje automático entrenado a través de fotografías reales, se rellenen los detalles de baja resolución. En palabras de mi compañero Christian Collado, el cual explica RAISR al detalle, usamos el aprendizaje automático y entrenamos en pares de imágenes, una de baja calidad, y una alta, para encontrar filtros que, cuando se aplican selectivamente a cada píxel de la imagen de baja resolución, recrearán detalles que son de una calidad comparable a el original.

Sea como fuere, la pérdida de calidad de hace presente, y el RAISR jamás obtendrá los resultados de un zoom óptico real. Sin embargo, teniendo en cuenta la carencia de doble sensor y la pérdida prácticamente inapreciable de calidad, no podemos más que aplaudir el trabajo de Google.

¿Y qué hay del Visual Core?

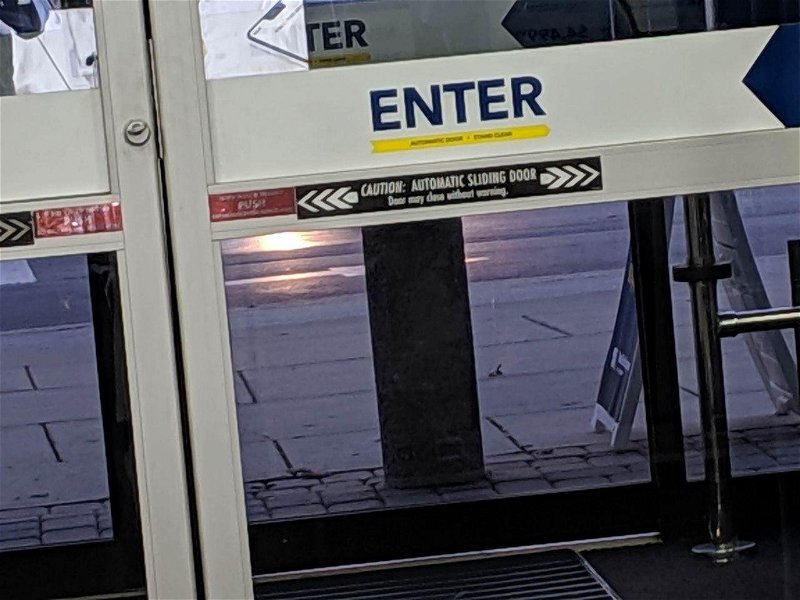

A la izquierda, fotografía con la app nativa de Instagram, a la derecha, fotografía con el procesado del Visual Core Chip

Hay algo que hace que el Google Pixel tome mejores fotos que cualquier otro teléfono dentro de las aplicaciones. En colaboración con Intel, Google desarrolló un procesador que permitía a los desarrolladores el acceso al HDR+ de Google. ¿Qué significa esto? Que si tomas una fotografía con la app de cámara de Instagram o WhatsApp, la aplicación utilizará el HDR+, por lo que no tendrás apenas pérdida de calidad, como sí sucede en el resto de terminales.

Al hacer una fotografía en un smartphone "no Pixel", la cámara es incapaz de acceder a las librerías propietarias en las que se encuentran los archivos necesarios para procesar la imagen tal y como lo haría el teléfono en la app nativa de cámara. El resultado es una fotografía de mala calidad.

Esto es algo importante, ya que abre las puertas a la integración del hardware y el software propio con aplicaciones de terceros, algo que solo veíamos en los terminales de Apple. Con Visual Core nos olvidamos de perder calidad en las aplicaciones compatibles aunque, eso sí, un año después siguen siendo bastante pocas.

Todo lo comentado, también en la cámara delantera

There is FOR SURE no beauty smoothing happening with this Pixel 3 camera. Holy sharpness. pic.twitter.com/apvGO6xQYb

— Marques Brownlee (@MKBHD) 9 de octubre de 2018

Los fabricantes han normalizado que la cámara delantera debe ser notablemente inferior a la trasera. Un auténtico sinsentido teniendo en cuenta el auge de los selfies y la importancia de este tipo de fotografía en redes sociales. Google entiende que el selfie importa tanto como la cámara trasera, y si bien la calidad de su cámara frontal no iguala a la principal, es indiscutiblemente la mejor cámara selfie del mercado.

El grado de detalle que logra sacar es sencillamente impresionante, amén de la cantidad de luz que rescata gracias a su procesado. Por último, el modo retrato en esta cámara delantera es tan llamativo como el de la trasera, algo que ningún rival logra.

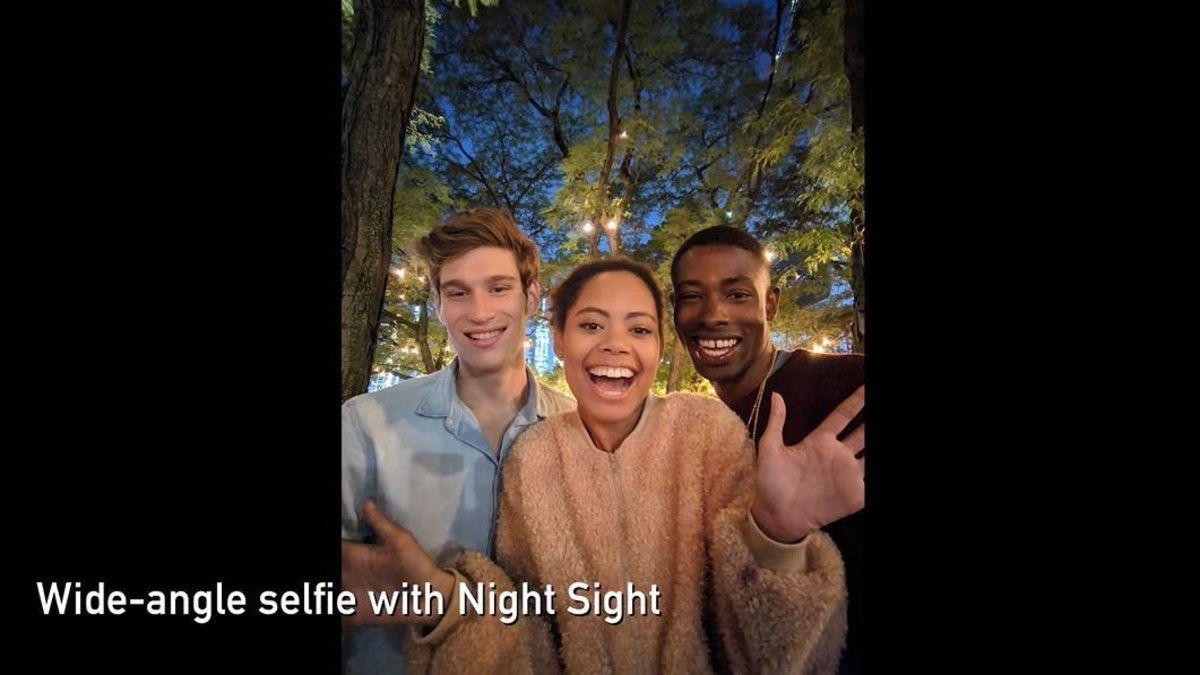

La carne en el asador, vamos con los Google Pixel 3

Si bien pudiera parecer que los Google Pixel 3 tan solo han obtenido leves mejoras en el sensor y la aplicación de cámara, de nuevo encontramos grandes mejoras que no conocemos hasta que no hablamos con Google. Los Google Pixel 3 y 3 XL cuentan con un sensor principal de 12.2 megapíxeles con apertura f/1.8 y Dual Pixel, así como con dos sensores delanteros de 8 megapíxeles, uno normal, y otro más angular para realizar fotografías de grupo. Según Google, obtenemos un 189% más de contenido en la fotografía gracias al segundo sensor, algo a tener en cuenta.

Una vez comentado el hardware, es hora de hablar de las novedades exclusivas que llegan con los Google Pixel 3 y 3 XL, y es que hay muchísimo trabajo detrás de todo lo que son capaces de hacer estos terminales.

Synthetic Fill Flash

Google ha pensado en cómo un fotógrafo trata de conseguir más luz en una fotografía. A la hora de disparar de forma profesional, es bastante habitual utilizar reflectores de luz, elementos que permiten reflejar la luz directamente en cualquier zona que queramos de la imagen. Google ha tratado de reflectar la luz de forma computacional, algo que, de nuevo, jamás se había logrado en el territorio de los smartphones.

Uno de los principales problemas a los que se enfrenta un fotógrafo es a la correcta exposición del rostro en los modelos. Google trata de emular la luz proyectada con un reflector mediante software, aplicando exposición al rostro de forma selectiva.

Mediante Machine Learning y con el trabajo ya aprendido sobre cómo analizar los rostros de los sujetos, los nuevos Google Pixel 3 añaden exposición extra a los mismos, de forma selectiva y emulando de la forma más natural posible los reflectores que utilizamos los fotógrafos para acabar con las sombras en los rostros. Otra consecuencia de esto, de nuevo, es evitar que las luces altas se descontrolen.

En un móvil "normal", si tu rostro está mal iluminado y el fondo tiene bastante luz, o bien saldrás completamente oscuro, o bien al enfocar en el rostro toda la exposición irá al mismo, y el fondo perderá información. Con Synthetic Fill Flash, Google logra de nuevo exponer correctamente tanto sujeto como fondo, clave principal en fotografía, y uno de los mayores retos a la hora de que un profesional ajuste los controles de su cámara.

Night Sight

Lejos de ser un "modo noche" al uso, Night Sight está planteado para aquellas situaciones en las que te resultaría imposible hacer una fotografía, debido a las pésimas condiciones lumínicas. Esto, se logra tomando una serie de fotografías de baja exposición, renunciando al zero shutter lag -que el teléfono dispare de inmediato-, y tomando unos pocos segundos para hacer la foto. El resultado final ofrece una fotografía de unos 5 segundos de exposición, por lo cual tenemos una cantidad de luz extra bastante considerable.

A pesar de la ausencia total del luz, el Google Pixel 3 es capaz de analizar los colores que debe tener la foto gracias al Machine Learning, algo que hará que, a pesar de las malas condiciones, no obtengamos fotos pálidas e irreales.

De nuevo, repetimos que no es un modo noche, y que no está pensado para hacer fotografías "bonitas". Se trata de un modo para situaciones extremas, para recuperar información que es prácticamente imposible de recuperar de otro modo.

Computational RAW

Acabo de meter un DNG del Pixel 2 XL con el RAW computacional. 11 megas. Se nota el extra de información y la fotografía no está procesada. Esto es un antes y un después en fotografía pic.twitter.com/jPTuhmE6H4

— Ricardo Aguilar (@MrBrickerTech) 11 de octubre de 2018

Como fotógrafo, he de decir que esta es la característica que más me ha impactado en los nuevos Google Pixel 3, y considero, personalmente, que supone un antes y un después en la fotografía móvil. En cualquier dispositivo, al disparar en formato RAW obtenemos el archivo tal y como lo ha recogido el sensor, un RAW en bruto que debemos revelar.

En lugar de obtener el archivo DNG tal y como lo arrojaría la cámara, el Google Pixel 3 realiza una ráfaga de fotografías que se fusionan en una sola. Esto nos da como resultado un archivo DNG con bastante más información, sobre el que podremos trabajar de forma más profunda respecto a un disparo en JPEG.

La diferencia con el resto de la industria, en palabras de Marc Levoy, es que el Google Pixel 3 arroja un archivo DNG que es resultado de alinear y fusionar múltiples fotografías, por lo que obtendremos un resultado bastante similar al que encontramos en una DSRL, con bastante más información disponible para editar nuestra fotografía.

Super Res Zoom

A la izquierda, fotografía con el Google Pixel 2 XL y Super Res Zoom, a la derecha, fotografía con el zoom x2 clásico

Mediante fotografía de ráfaga y haciendo uso de la estabilización óptica, el Pixel logra aumentar la resolución de las imágenes y hacer lo que han denominado Super Res Zoom. Al hacer la fotografía en este modo, son capaces de obtener el espectro de color completo, sin necesidad de interpolación cromática -concepto que te hemos explicado antes, en el que se combina el RGB para crear una imagen a color-.

Google nos explica que el proceso de interpolación cromática no deja de ser una operación matemática, y que toda operación matemática acaba arrojando ruido a la fotografía. Al eliminar esta interpolación son capaces de generar una imagen con unos niveles de ruido mínimos. Gracias a esto, son capaces de ofrecer unos resultados similares a un zoom 2X óptico aplicando tan solo un zoom 1.2X, gracias de nuevo, al combinado de la ráfaga de fotos que lanza -recordemos de nuevo que el Pixel se vale de unas 15 fotografías combinadas en cada modo-.

Google carece de zoom 2X, pero con los nuevos algoritmos de aprendizaje es capaz de de aumentar la resolución al aumentar las imágenes. Esto se traduce en fotos zoom de gran calidad, aunque sigue por detrás de los sensores telefoto.

La explicación de Google para no incluir el segundo sensor telefoto para realizar el zoom es que tener más cámaras no significa tener más capacidades, de hecho, el sensor secundario que montan los gama alta es más pequeño y de menor calidad que el principal, por lo que acabamos obteniendo imágenes notablemente peores que las que arroja el sensor principal.

Por ejemplo, a la hora de hacer modo retrato, fabricantes como Samsung o Apple se valen del segundo sensor para hacer el zoom, mientras que en el Google Pixel se emplea el Dual Pixel con el sensor principal, obteniendo así la misma calidad que en cualquier otra fotografía.

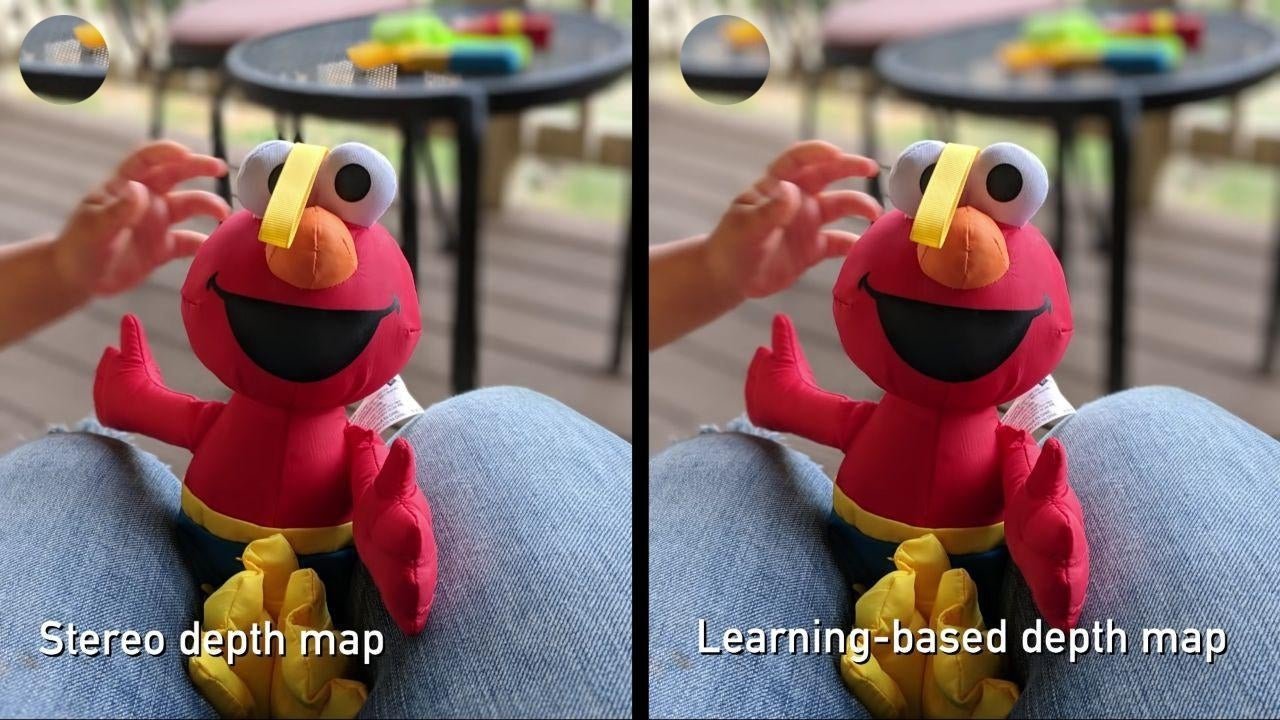

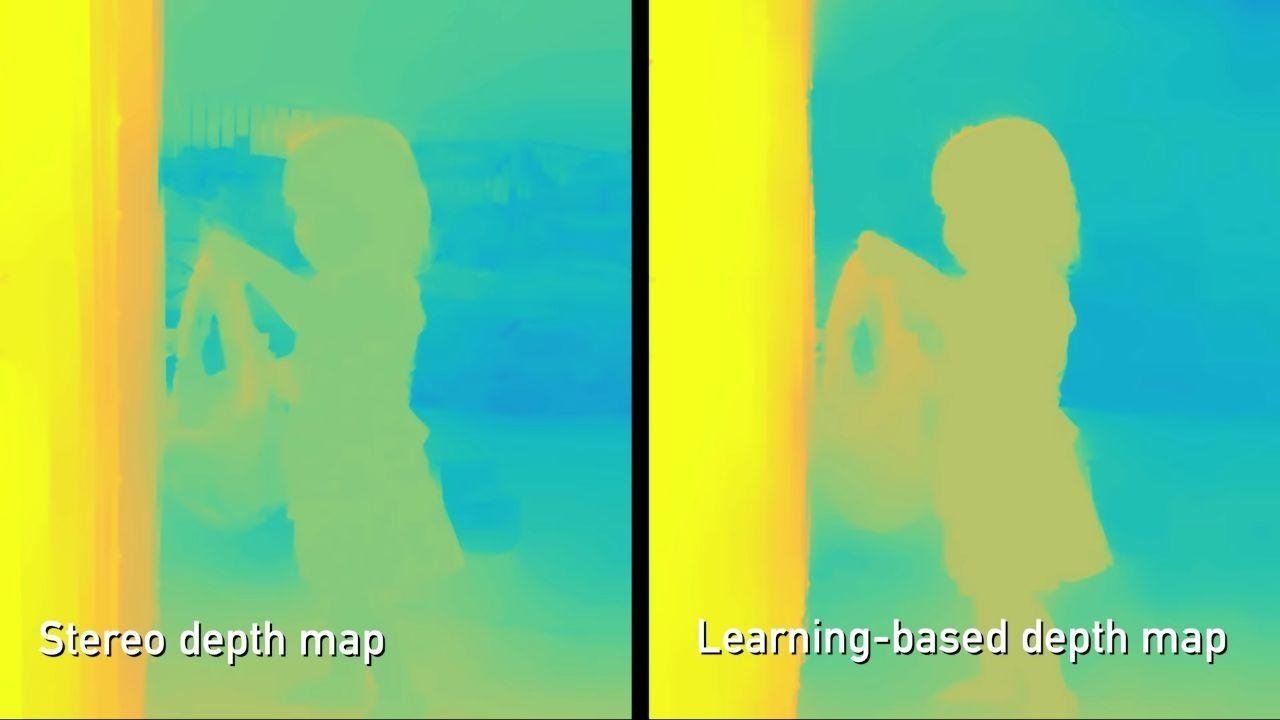

Learning Based Depth Map

Anteriormente, te hemos contado que el Google Pixel es capaz de crear un mapa de profundidad. En el tercer modelo han mejorado aún más la forma en la que el teléfono obtiene el mismo, para conseguir más información que permita un mejor recorte y, sobre todo, una mejor interpretación de la profundidad de campo.

Según Levoy, ahora se utiliza un algoritmo mejorado basado en el aprendizaje automático para computar la información estéreo del Dual Pixel -la división que ya te hemos contado que hace de la imagen-. De esta forma,, logran un desenfoque bastante más uniforme, algo que podrás apreciar claramente en las siguientes imágenes.

Como podemos apreciar, con el nuevo algoritmo el desenfoque es aún mejor, y se aplica incluso a zonas en las que en la generación anterior era incapaz de aplicarse. Esto se debe, como te hemos contado, a nuevos algoritmos de aprendizaje automático que permiten al Pixel 3 obtener fotografías con un mapa de profundidad bastante más avanzado.

Google intenta de nuevo situarse a la cabeza con el modo retrato, y queda patente que el resto de firmas saben que su método es el más apropiado. Apple también ha incluido el Dual Pixel en un único sensor en su iPhone XR, permitiendo así que se cree el primer terminal de Apple con una sola cámara capaz de realizar el modo retrato.

Los inconvenientes de la interpretación de Google

Creemos y esperamos haberte explicado suficientemente bien cómo funcionan las cámaras de los Google Pixel, por lo que ahora toca hablar del lado negativo. Decir que, como siempre, la fotografía tiene una gran parte de subjetividad, por lo que es necesario intentar integrar todos los puntos de vista posibles a la hora de analizar las posibilidades de imagen que nos ofrecen los smartphones.

El primer inconveniente es la ausencia de modo manual en los Google Pixel. La justificación es clara, son móviles enfocados para el Point And Shot y... sinceramente, no vas a procesar a mano una imagen mejor de lo que lo hace la IA de Google. No obstante, cuando pagamos 1.000 euros por un teléfono no es mal avenida la posibilidad de controlar al completo nuestra cámara, tal y como podemos hacer en un Huawei P20 Pro o Samsung Galaxy Note 9.

Tanto Google como Apple, actuales reyes de la fotografía, no permiten controles manuales en su app de cámara nativa, ¿casualidad? Ambas compañías entienden que las cámaras de los smartphones están destinadas a enfocar y disparar, por lo que evitan cualquier tipo de distracción en sus aplicaciones.

En segundo lugar, y debido a cómo funciona el modo retrato de Google, no tenemos vista previa a la hora de lanzar la fotografía, solo podemos ver el desenfoque -si es que lo ha hecho-, cuando realizamos la foto. Esto cobra sentido ya que el procesado se hace a posteriori pero... Este año parece que Google tiene un problema.

Hasta donde llegan nuestras informaciones, el iPhone XR es capaz de ofrecer vista previa del desenfoque en modo retrato, a pesar de que utiliza un solo sensor y la tecnología del Dual Pixel. Al igual que han mejorado todos los aspectos anteriormente comentados, estamos seguros de que Google tiene la tecnología suficiente como para averiguar una solución a este problema, y ofrecer una vista preliminar del desenfoque que vamos a crear.

Por otro lado, encontramos que, en ocasiones, el procesado de Google se hace excesivo. Si bien en la inmensa mayoría de fotografías el resultado está por encima del resto de sus rivales, el HDR+ puede llegar a destrozar la fotografía, creando un resultado demasiado falso. He aquí un claro ejemplo.

La fotografía luce espectacular, pero el resultado es técnicamente irreal, y el HDR excesivo

La no incorporación del doble sensor también conlleva que el modo retrato esté bastante más limitado. Al utilizar la información del sensor principal con ayuda del Dual Pixel, el Google Pixel tiene serios problemas a la hora de realizar retratos a objetos que están a ciertas distancias, algo que no sucede con el resto de rivales. Además, como bien te hemos comentado anteriormente, el zoom, si bien se ayuda del RAISR y de algoritmos de aprendizaje, sigue sin llegar al nivel que ofrece un sensor teleobjetivo.

Una de las principales diferencias con los iPhone es que el Google Pixel no aplica un gradiente de profundidad. En primer lugar, debes ver cómo funciona este en las cámaras profesionales, y cómo afecta la falta del mismo, tanto para bien como para mal. Aquí tienes la misma fotografía, tomada con una DSRL y por otro lado tomada con el Pixel. Como puedes ver, tanto la parte superior -el gorro-, como la parte inferior -la bufanda-, tienen un ligero desenfoque en la DSLR, mientras que el Pixel lo mantiene todo en foco.

Esto es un efecto producido por la propia física del objetivo y varía en función de la apertura focal, algo que el iPhone intenta imitar, aunque no de la mejor forma. La cuestión está en cómo valorar si compensa más mantenerlo todo en foco como el Google Pixel, o aplicar un gradiente artificial como hace el iPhone. En esta fotografía puedes ver cómo actúan ambos extremos, el Pixel manteniendo el foco en zonas que teóricamente no debería, y el iPhone aplicando un gradiente poco natural, que da más sensación de falta de foco por problemas de la cámara que por una búsqueda intencionada.

Para mi, por ejemplo, el Pixel toma en este lado de la imagen la decisión equivocada. Pero es que partimos de la base de que es una es Ena complicada. La otra (la estatua) tiene menos explicación. No entiendo lo del Pixel ahí. pic.twitter.com/CA77TckNU5

— Angel Jiménez de Luis (@angeljimenez) 12 de octubre de 2018

¿Mantenemos todo a foco o creamos un desenfoque gradual artificial que acaba creando halos alrededor del sujeto? En mi opinión, la decisión de Google es la correcta, aunque como siempre, está el punto de vista contrario, que defiende que el gradiente del iPhone es más natural.

Por último, y a falta de comprobar cómo son estos tiempos en el Google Pixel 3 -del que tendremos review en unos días-, al tomar una fotografía el terminal demora bastante en procesar. De hecho, si tomas varias instantáneas seguidas, pongamos unas 10 o 15, el terminal puede llegar a tardar cerca o más de medio minuto en ofrecerte el resultado final en la galería. Es algo a lo que estamos dispuestos a sufrir a cambio de tan espectaculares resultados, pero que nos gustaría ver mejorado.

Conclusiones finales

Como has podido ver hay mucho, muchísimo detrás de la tecnología que alberga la cámara de los Google Pixel, y tan solo te hemos contado lo esencial de forma sencilla, para que puedas entender cómo funciona. Aunque pueda parecer excesivo para algunos pagar las cifras que se piden por los terminales de gama alta, cuando vemos el desarrollo que tienen estos terminales a sus espaldas entendemos bastantes cosas. Detrás de la fotografía computacional de Google hay toda una eminencia de la Universidad de Stanford liderando un equipo de algunos de los mejores ingenieros del mundo, especializados en Machine y Deep Learning.

Google es, junto a Apple, la firma que mejor está haciendo sus deberes en el apartado fotográfico. Dos interpretaciones distintas, debido a la radical diferencia entre los procesados de una y otra cámara. En nuestra opinión, el contraste extra y el detalle son claves en el resultado final, pese a los problemas que pueda haber debido a la falta de doble cámara y exceso, en ocasiones, del procesado que aplica el Pixel.

El teléfono ha dejado, desde hace tiempo, de ser un dispositivo para realizar fotografías testimoniales. Cada día trata más y más de ofrecer resultados similares a lo que nos daría una DSLR y aunque esto sea una tarea prácticamente imposible, para el usuario medio las diferencias son cada vez más ínfimas.

Nos apasiona ver el empeño que pone Google en crear, año tras año, una cámara sin rival. Una tecnología que se olvida del marketing, de añadir cámaras para ver quién la tiene más grande, y de sobresaturar el software de la misma con funciones que usaremos... ¿Una, dos veces?

La fotografía computacional es presente y futuro, un proyecto que Marc Levoy inició con gran empeño y que se asienta cada vez, permitiéndonos tener todo un monstruo de la toma de capturas en el bolsillo.