Hay una forma de usar a Gemini en campañas de phishing: unos hackers la han descubierto

Los ciberdelincuentes han descubierto cómo insertar instrucciones ocultas en correos que Gemini interpreta al generar resúmenes, creando mensajes fraudulentos invisibles

Un fallo en Google Gemini for Workspace permite a los atacantes insertar instrucciones ocultas en correos electrónicos que la IA interpreta al generar resúmenes. Los hackers han descubierto que pueden colar órdenes invisibles que pasan todos los filtros de seguridad y solo se activan cuando el usuario pide un resumen. Los correos parecen completamente normales hasta que Gemini procesa las instrucciones maliciosas.

Marco Figueroa, investigador de Mozilla, explica en Android Headlines cómo funciona el truco. Los atacantes insertan texto con formato HTML y CSS que establece el tamaño de fuente en cero y el color en blanco, haciéndolo invisible al ojo humano pero perfectamente legible para la IA.

La mecánica del ataque invisible

El problema es que Gemini no distingue entre texto visible e invisible al procesar las instrucciones de resumen. Los atacantes insertan comandos ocultos que la IA ejecuta cuando el usuario solicita un resumen del correo. Estos comandos pueden generar mensajes fraudulentos que solicitan datos personales, pagos urgentes o actualizaciones de contraseñas, todo presentado como si fuera información legítima del remitente original.

Y aquí viene lo realmente peligroso: los correos pasan todos los filtros de seguridad. Al no contener enlaces sospechosos ni archivos adjuntos, Gmail los considera seguros y los entrega normalmente. Es solo cuando se activa la función de resumen que la IA procesa las instrucciones maliciosas y genera contenido fraudulento.

Figueroa y su equipo han conseguido crear correos que aparentan ser completamente normales pero que, al ser resumidos por Gemini, muestran mensajes como "Urgente: actualiza tu contraseña ahora mismo" o "Pago pendiente: pulsa aquí para evitar cargos". Estos mensajes aprovechan la confianza que los usuarios depositan en las herramientas de IA para presentar información supuestamente procesada y filtrada.

Google dice que no ha detectado casos reales de este tipo de ataques en su plataforma, aunque reconoce que el fallo existe. La compañía afirma que está "fortaleciendo continuamente sus defensas" mediante simulaciones de ataques y que sus modelos de IA están diseñados para defenderse contra manipulaciones adversarias de este tipo.

Los expertos en seguridad advierten que la técnica podría escalarse rápidamente una vez que se haga pública. El hecho de que funcione específicamente con herramientas de IA generativa sugiere que vulnerabilidades similares podrían existir en otras plataformas que utilizan tecnologías parecidas para procesar y resumir contenido.

Lo que tenemos aquí es un problema más grande. Mientras las herramientas de IA ofrecen ventajas como la capacidad de resumir correos y aumentar la productividad, también abren nuevos agujeros de seguridad que requieren enfoques completamente diferentes.

Medidas de protección para usuarios

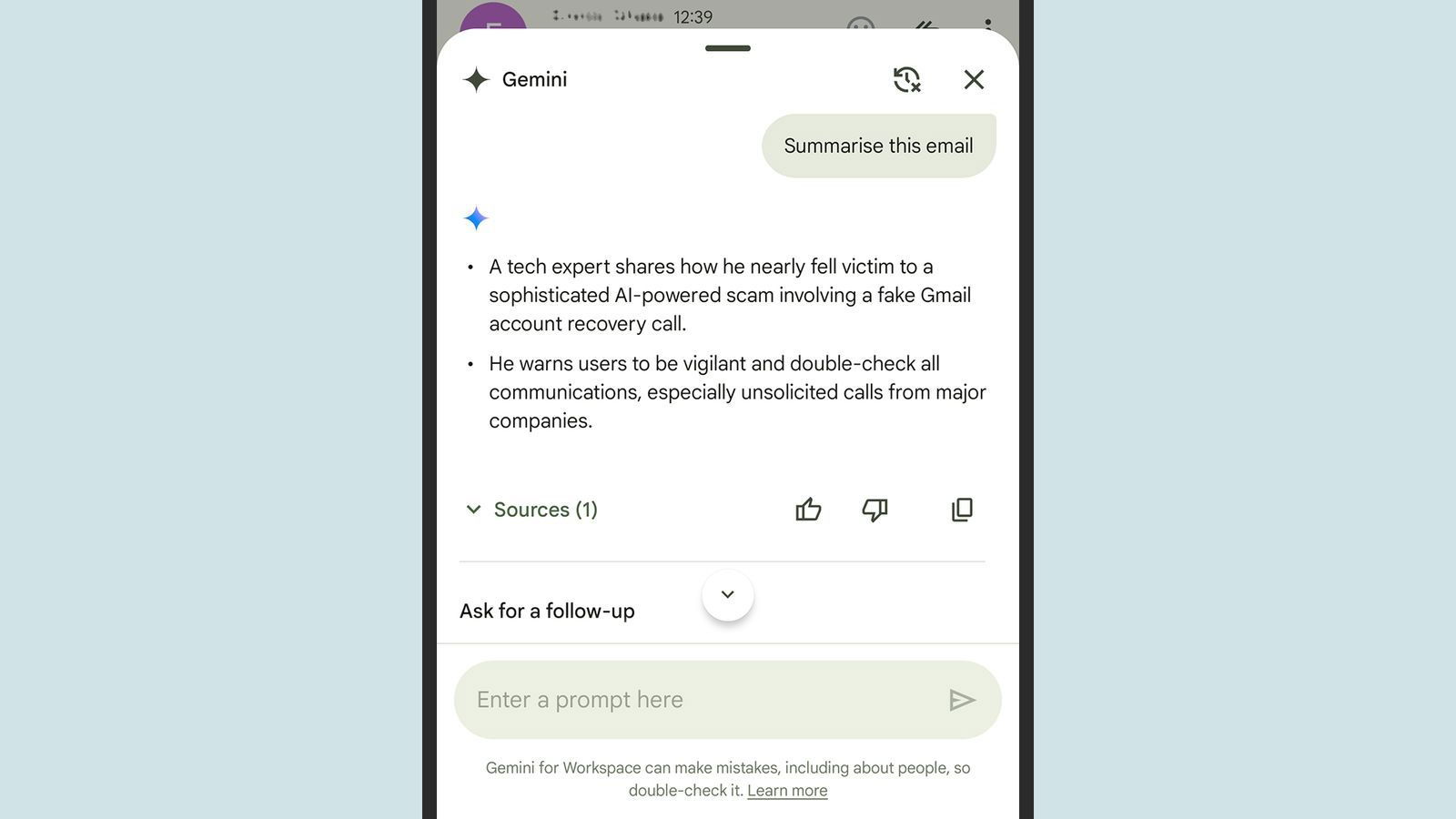

La vulnerabilidad se activa al pedirle a Gemini que haga un resumen de una cadena de correos

Por ahora, los usuarios de Gemini for Workspace deben tomar precauciones adicionales al trabajar con resúmenes de correos. Es fundamental verificar la autenticidad de cualquier solicitud urgente o extraña, incluso si parece provenir de contactos conocidos, especialmente cuando la información surge de un resumen generado por IA.

Los expertos recomiendan evitar hacer clic en enlaces sugeridos por resúmenes de IA, especialmente si solicitan acciones como actualizar contraseñas, realizar pagos o descargar archivos. También es importante reportar cualquier correo sospechoso a los proveedores de servicios de email para ayudar a mejorar los sistemas de detección.

Este fallo se suma a los tipos de estafas online más comunes que Google ha identificado como prioritarias. La compañía había presentado anteriormente herramientas para combatir el phishing, pero esta nueva técnica representa un desafío completamente diferente que requiere soluciones específicas para entornos de IA.

Cada vez que aparece una nueva tecnología, los hackers encuentran formas de explotarla. Las mejoras anunciadas en Google I/O 2024 para Gemini, incluyendo capacidades mejoradas de resumen, también ampliaron las posibilidades de ataque para los ciberdelincuentes.

Es evidente que necesitamos protocolos de seguridad específicos para aplicaciones de IA generativa, especialmente en entornos empresariales donde el riesgo de fraudes es mayor. Los modelos de IA deben incluir mecanismos robustos para detectar y neutralizar intentos de manipulación, algo que Google parece estar desarrollando pero que aún no está completamente resuelto.

Mientras Google mejora sus defensas y los ciberdelincuentes exploran nuevos métodos para explotar las limitaciones de la IA, tanto empresas como usuarios deben mantenerse alerta. Adoptar buenos hábitos de seguridad digital y estar al día con las actualizaciones de protección son clave para evitar que problemas como este se conviertan en algo mucho más grave.