Unos hackers intentan clonar Gemini con más de 100.000 prompts

Google detecta y frena una campaña masiva de más de 100.000 consultas que buscaba copiar el funcionamiento interno de Gemini para crear modelos rivales

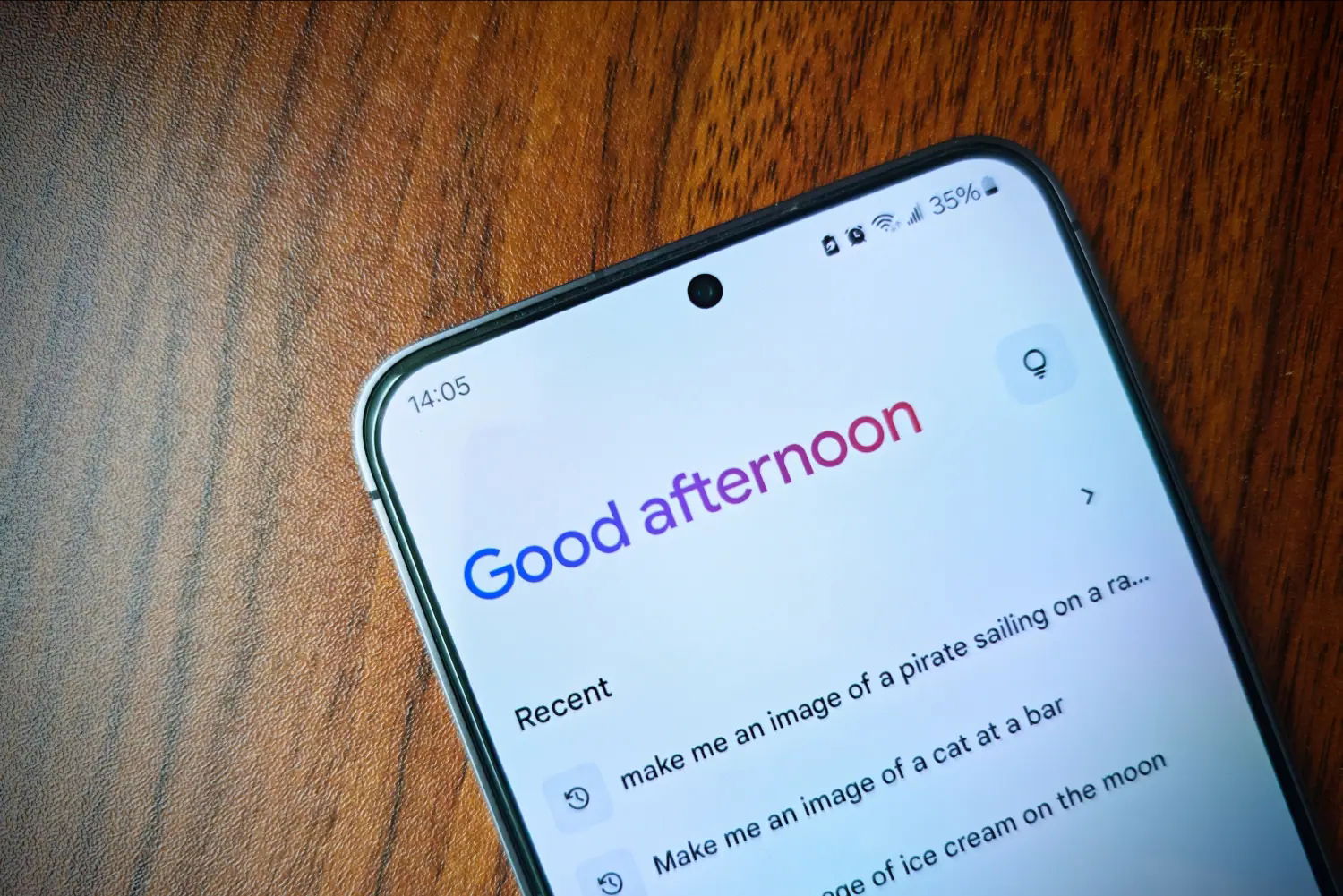

El mundo de la inteligencia artificial se ha convertido en un campo de batalla donde ya no solo importa quién lanza el mejor modelo, sino quién consigue proteger mejor sus secretos. Google acaba de revelar que varios atacantes han intentado clonar Gemini lanzando una ofensiva masiva basada en consultas constantes. No buscaban tirar el servicio, sino extraer los patrones de razonamiento internos para replicar sus capacidades de forma externa.

Según ha publicado Android Headlines, esta campaña de destilación utilizó más de 100.000 entradas para mapear cómo responde el chatbot ante diferentes estilos y temas. Esta técnica permite a empresas o investigadores independientes entrenar modelos competidores robando propiedad intelectual sin necesidad de hackear infraestructuras complejas, simplemente abusando del acceso a la API que Google ofrece a desarrolladores.

El ataque de destilación: ¿cómo han intentado robar la IA de Google?

Se ha usado un ataque de destilación para intentar clonar a Gemini

Para entender la magnitud del problema, conviene recordar que la seguridad en los servicios de la compañía siempre está bajo la lupa. No es la primera vez que se enfrentan a un escenario crítico, como ya ocurrió con la filtración que comprometió datos de miles de millones de usuarios de Gmail el año pasado. En esta ocasión, el objetivo no era el usuario final, sino el corazón algorítmico que hace que Gemini funcione.

Este tipo de ofensivas se han vuelto el pan de cada día en el sector. De hecho, hace apenas unos meses vimos cómo OpenAI confirmaba una brecha de seguridad masiva que exponía datos sensibles, demostrando que los sistemas de IA son hoy el objetivo prioritario. El interés por clonar estas herramientas se explica por su valor de mercado: Gemini ya roza los 750 millones de usuarios, consolidándose como un activo estratégico fundamental para Google en su guerra comercial.

Afortunadamente, los sistemas de monitorización detectaron el volumen inusual de consultas en tiempo real y bloquearon las cuentas implicadas. Google ha aprovechado para recordar que su propia IA también sirve como escudo, algo que ya demostraron al descubrir el primer fallo de seguridad gracias a la inteligencia artificial hace poco más de un año. Es una dinámica de gato y ratón donde la tecnología es, a la vez, el arma y la defensa.

La compañía ha confirmado que no ha habido brecha de datos personales, pero ha endurecido los protocolos de acceso a sus modelos más avanzados. Los atacantes intentaron ajustar idiomas y tipos de preguntas para forzar al sistema a exponer su "cadena de pensamiento" interna. Este tipo de prácticas ponen en riesgo la ventaja competitiva de gigantes tecnológicos que invierten miles de millones en investigación y desarrollo de redes neuronales.

Parece que el futuro de la red no se decidirá solo por quién ofrece el asistente más inteligente, sino por quién es capaz de blindar su lógica interna ante ataques masivos. El uso de la API para generar código malicioso o correos de phishing también forma parte del informe de amenazas de Google. Es la confirmación de que la IA generativa es una herramienta tan potente como peligrosa si cae en las manos equivocadas.

Al final, la seguridad absoluta no existe, y menos en un entorno tan nuevo como el de los modelos de lenguaje. Google ha conseguido frenar este intento de clonación, pero la lección es clara: el espionaje industrial se ha vuelto digital y automatizado. Habrá que ver si las nuevas medidas de contención son suficientes para evitar que alguien acabe consiguiendo una copia barata del modelo más avanzado de la gran G.