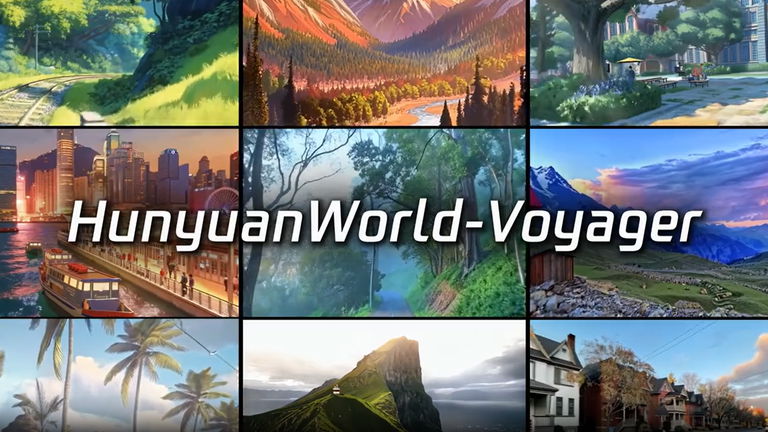

De una foto a un mundo virtual: así funciona HunyuanWorld-Voyager de Tencent

El modelo abre el camino hacia entornos digitales más consistentes y realistas.

El gigante tecnológico chino Tencent ha presentado esta semana HunyuanWorld-Voyager, un modelo de inteligencia artificial de código abierto capaz de generar secuencias de vídeo con coherencia espacial a partir de una sola imagen. El sistema permite que los usuarios definan un recorrido de cámara (adelante, atrás, giros o desplazamientos laterales) y luego crea un clip que simula la exploración de un mundo virtual.

Lo que lo distingue de otros generadores de vídeo es su capacidad de producir información RGB y de profundidad de forma simultánea, lo que habilita la reconstrucción 3D directa sin necesidad de técnicas de modelado tradicionales. Aunque el resultado no son modelos tridimensionales “puros”, el efecto es muy similar: las escenas mantienen proporciones y posiciones relativas de los objetos cuando la cámara se mueve, algo inusual en la mayoría de sistemas actuales.

Cada generación produce unos 49 fotogramas, equivalentes a dos segundos de vídeo, pero se pueden encadenar múltiples clips para lograr secuencias de varios minutos. Eso sí, las limitaciones aparecen al intentar rotaciones completas de 360 grados, donde pequeños errores acumulados en la coherencia terminan rompiendo la ilusión.

Coherencia espacial y límites de la generación

La clave de Voyager está en cómo combina el aprendizaje de patrones con un bucle de retroalimentación geométrica. Durante la generación, el sistema transforma cada fotograma en una nube de puntos 3D que luego proyecta de nuevo a 2D, creando imágenes parciales que sirven de referencia para los siguientes fotogramas. De este modo, obliga al modelo a mantener la consistencia entre lo que “vio” antes y lo que está generando ahora.

Este método ofrece un resultado mucho más consistente en el espacio que generadores como Sora, que se centran únicamente en producir fotogramas plausibles uno tras otro. Sin embargo, sigue siendo un enfoque basado en el reconocimiento de patrones de entrenamiento —más de 100.000 clips, incluidos escenarios de Unreal Engine—, y no en una comprensión real del 3D. Por ello, aunque logra escenas coherentes durante varios minutos, no puede evitar que los errores se acumulen en secuencias más largas.

El modelo se estructura en dos grandes bloques: la generación simultánea de color y profundidad, y la gestión del “world cache”, una memoria de puntos 3D construida a partir de lo generado previamente. Esta memoria permite mantener los objetos en su sitio cuando la cámara cambia de perspectiva, mejorando la estabilidad visual.

El lanzamiento de Voyager se suma a la carrera por la generación de mundos virtuales mediante IA. Google anunció en agosto Genie 3, que permite crear entornos interactivos en tiempo real a partir de texto, aunque aún no está disponible al público. Dynamics Lab, por su parte, ofrece Mirage 2, que permite a los usuarios subir imágenes y transformarlas en entornos jugables desde un navegador. Frente a estas propuestas, Tencent apuesta por el terreno de la producción audiovisual y la reconstrucción 3D, con un enfoque claro en aprovechar los datos de profundidad.

Aunque todavía está lejos de sustituir el modelado 3D profesional, Voyager representa un avance significativo hacia herramientas más accesibles y flexibles. Su mayor aportación es demostrar que la consistencia espacial puede integrarse en la generación de vídeo por IA, un paso clave en el camino hacia mundos virtuales más estables, realistas y navegables.