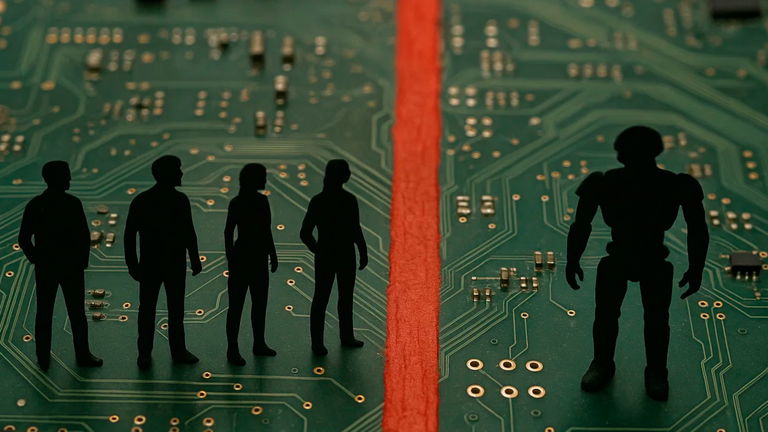

Más de 200 líderes piden que se establezcan "líneas rojas" a la IA

La inteligencia artificial avanza a un ritmo tan acelerado que muchos expertos consideran urgente establecer líneas claras que esta tecnología nunca debería cruzar. Esa es la esencia de la iniciativa Global Call for AI Red Lines, presentada este lunes y respaldada por más de 200 personalidades, entre ellas antiguos jefes de Estado, diplomáticos, científicos, galardonados con el Nobel y directivos de empresas de inteligencia artificial. El objetivo es alcanzar un acuerdo político internacional antes de 2026 que defina prohibiciones comunes, como impedir que la IA se haga pasar por un ser humano o que tenga la capacidad de autorreplicarse.

Una llamada preventiva y global

La propuesta parte de la convicción de que no se puede esperar a reaccionar tras un accidente grave, sino que es necesario prevenir riesgos de gran escala antes de que se materialicen. Así lo explicó Charbel-Raphaël Segerie, director ejecutivo del Centro Francés para la Seguridad en IA (CeSIA), una de las organizaciones impulsoras junto con The Future Society y el Centro para la Inteligencia Artificial Compatible con los Humanos de la Universidad de Berkeley. Como resumió Segerie: “Si los países aún no saben qué quieren hacer con la IA, al menos deben acordar lo que la IA nunca debe hacer”.

Entre los firmantes se encuentran nombres de enorme peso en el debate sobre esta tecnología: Geoffrey Hinton, considerado uno de los padres de la inteligencia artificial moderna; Wojciech Zaremba, cofundador de OpenAI; Jason Clinton, responsable de seguridad de Anthropic; o Ian Goodfellow, investigador en Google DeepMind. También la periodista filipina Maria Ressa, premio Nobel de la Paz, que aprovechó la Asamblea General de Naciones Unidas para subrayar la necesidad de poner fin a la “impunidad de las grandes tecnológicas” mediante una verdadera rendición de cuentas a nivel global.

Aunque existen precedentes regionales, como la Ley de IA de la Unión Europea, que prohíbe determinados usos catalogados como “inaceptables”, o el acuerdo entre Estados Unidos y China para mantener las armas nucleares bajo control humano, no existe aún un marco común internacional. Para Niki Iliadis, directora de gobernanza global de IA en The Future Society, los compromisos voluntarios asumidos hasta ahora por las empresas “se quedan cortos” y resulta imprescindible crear una institución independiente con capacidad real para vigilar y sancionar.

El profesor Stuart Russell, una de las voces más influyentes en el campo, recordó que la industria nuclear no comenzó a construir reactores hasta tener mecanismos de seguridad frente a posibles explosiones, y exigió un enfoque similar para la inteligencia artificial: no avanzar en la construcción de sistemas de IA general hasta que existan garantías sólidas de seguridad. Para Russell, establecer líneas rojas no implica frenar el desarrollo económico o la innovación, sino garantizar que el progreso se produce sin generar riesgos existenciales. “La idea de que, para tener diagnósticos médicos con IA, debemos aceptar a cambio un AGI incontrolable es un sinsentido”, zanjó.

Lo que está en juego no es menor: se trata de definir si la humanidad será capaz de fijar unas reglas de convivencia global frente a una tecnología con capacidad de alterar por completo la economía, la política y la vida cotidiana. El llamamiento busca aprovechar la oportunidad de anticiparse a escenarios de difícil retorno, y aunque el consenso internacional parece un reto mayúsculo, la iniciativa deja clara una advertencia: no basta con confiar en la buena voluntad de las empresas, hace falta un marco firme y vinculante. El debate sobre los “límites rojos” de la inteligencia artificial apenas comienza, pero ya se perfila como una de las grandes discusiones políticas del siglo XXI.