El fin del robot tonto: la nueva IA de Google DeepMind que permite a los robots "pensar" y doblar la ropa

Google a través de DeepMind ha publicado sus avances respecto a la IA aplicada en robots, los descubrimientos y ejecuciones son bastante atractivos

El siguiente paso en la escala evolutiva de la IA podría estar aplicada directamente en algo físico como los robots. Hemos visto que la IA generativa está llegando a niveles de creación de contenidos que quizá jamás pensamos ver, la evolución inmediata sería tener este tipo de acciones en robots. Es lo que ha anunciado Google DeepMind con su proyecto de Gemini Robotics a través de dos nuevos modelos que trabajan en conjunto para crear robots que piensen antes de actuar.

Estos son los avances más recientes de robots con IA gracias al proyecto Gemini Robotics

Parte de este funcionamiento radica en la mejora de los LLM tradicionales con el simple hecho de aplicar razonamiento. De acuerdo con Google DeepMind, la IA generativa es importante para la robótica ya que puede "desbloquear funcionalidades generales". Los robots que fueron creados en una era previa a la IA requieren de un entrenamiento intensivo para poder aprender a ejecutar tareas y suelen tener fallos en otras para los cuales no fueron diseñados.

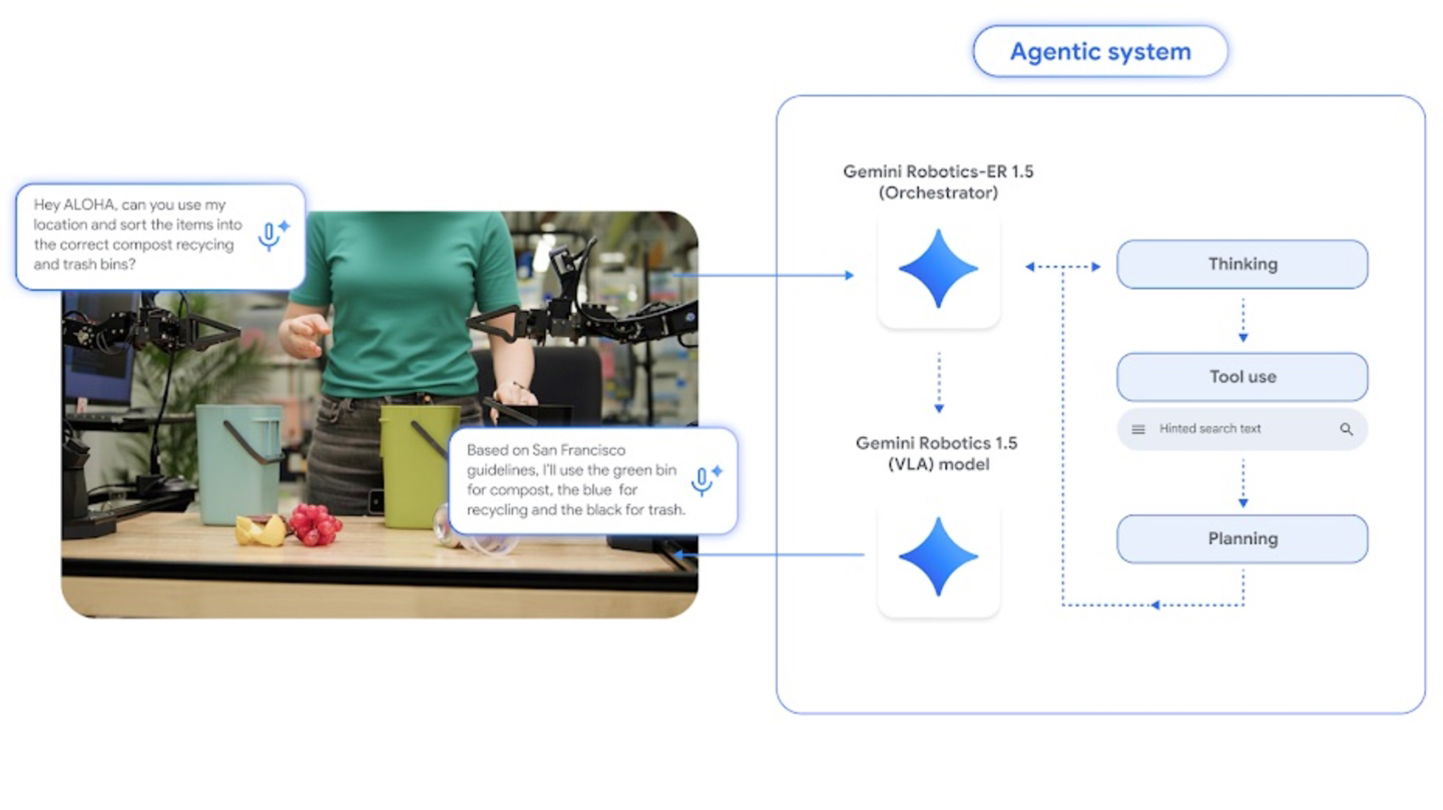

La directora de robótica de Google DeepMind, Carolina Parada, manifestó que se necesitan "meses para instalar una sola célula capaz de realizar una tarea". Con la IA podría cambiar todo el esquema de trabajo sin requerir de una programación aunque se enfrenten a trabajos o situaciones nuevas. Los dos modelos a los que se refiere Google DeepMind son para pensar y actuar conocidos como Gemini Robotics 1.5 y Gemini Robotics-ER 1.5, el primero es un modelo de "visión-lenguaje-acción" que genera las acciones en el robot y el segundo es el razonamiento incorporado.

¿Cómo serán los robots en el futuro con IA?

Google expone un ejemplo muy concreto respecto a una tarea que hacemos en el día a día que es separar la ropa para lavarla. ¿Cómo le dirías a un robo del futuro que lo haga? Lo primero es clasificar la ropa blanca y de color en dos pilas. ¿Qué haría el robot? Gemini Robotics-ER 1.5 realizaría el procedimiento de la solicitud con imágenes del entorno, que a su vez le generará las instrucciones en el lenguaje natural, los pasos para cumplir dicha tarea.

Gemini Robotics 1.5 en la parte de acción va a tomar estas instrucciones para realizar el procedimiento mientras utiliza la información visual previamente que guiará sus movimientos. Utilizará su pensamiento para cumplir con la solicitud. Google DeepMind se basa en los modelos de Gemini pero que se están perfeccionando para adaptarse al entorno físico, por lo que permitirá en el futuro a los robots realizar tareas más complejas. También hicieron el ejemplo con la clasificación de basura: composta, reciclaje y basura ordinaria.

Los modelos de razonamiento y vision-lenguaje-accion trabajando en conjunto

Google ya lo pone a prueba con dos robots, Aloha 2 y Apollo que es como una especie de humanoide. Aunque estamos lejos para que un robot haga acciones como un humano, son avances prometedores que sin duda alguna sentarán las bases para generar instrucciones robóticas contundentes que funcionen en robots físicos. Hace unos meses, Google DeepMin ya realizó las pruebas correspondientes con Gemini 2.0. Lo más interesante fue pedirle al robot que guardara un gorro en una mochila para un viaje a Londres. El robot sabía que llovería, por lo que también guardó un paraguas.