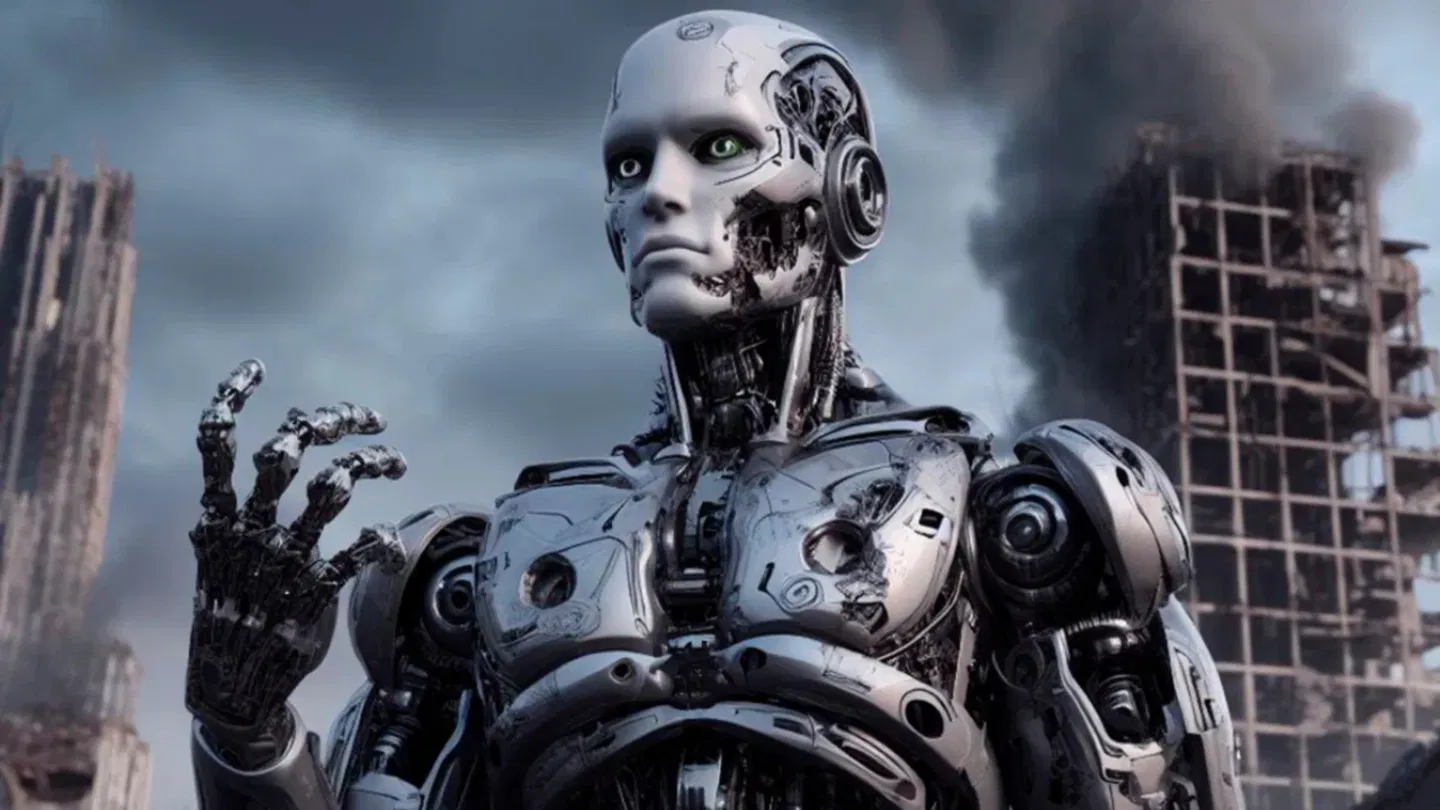

Los límites de lo que puede y no puede hacer la IA: líderes mundiales hacen un llamado a la falta de una política internacional

Líderes mundiales, cientificos, y muchas personalidades se dieron cita en una reunión previa a la 80a Asamblea de la ONU dejando en claro una cosa: la IA debe tener límites y los gobernantes del mundo deben establecerlo

Esta semana comenzó marcada por una reunión importante previa a la 80a Asamblea General de las Naciones Unidas en Nueva York. Más allá de los motivos principales hubo un espacio para pensar en un tema que nos concierne a todos por igual, la inteligencia artificial. Más de 200 exjefes de estados, diplomáticos, líderes de IA, científicos, entre muchos otros, estuvieron de acuerdo en que la IA debe tener un acuerdo internacional sobre el límite que no debe cruzar. Los ejemplos fueron claros: que la IA no se haga pasar como humano o que pueda ser duplicada.

La iniciativa "Global Call for AI Red Lines es oficial, firmada en conjunto con más de 70 organizaciones relacionadas con IA

Es uno de los acuerdos más serios que se han debatido desde que la IA forma parte de nuestra vida tecnológica. Tiene como finalidad que los gobiernos del mundo logren alcanzar un "acuerdo político" sobre límites para la IA a finales de 2026. Destaca en la firma el cofundador de OpenAI, Wojciech Zaremba, el CISO de Anthropic, Jason Clinton, el investigador de Google Deepmind, Ian Goodfellow.

Si las naciones aún no pueden ponerse de acuerdo sobre lo que quieren hacer con la IA, al menos deben ponerse de acuerdo sobre lo que la IA nunca debe hacer. Charbel-Raphaël Segerie, director ejecutivo del Centro Francés para la Seguridad de la IA (CESIA).

María Ressa, premio Nobel de la Paz, mencionó durante el discurso de apertura que pide "esfuerzos para acabar con la impunidad de las grandes tecnológicas a través de la rendición de cuentas global".

La inteligencia artificial aplicada al ámbito militar preocupa a los especialistas: en simulaciones tiende a escalar conflictos en lugar de frenarlos

Algunos países y regiones están conscientes, sin embargo falta el concenso mundial

La Ley de IA en la Unión Europea considera algunos usos como "prohibitivos" o "inaceptables" que son aceptados en otras regiones del mundo. Entre Estados Unidos y China existe un acuerdo donde las armas nucleares deben "permanecer bajo control humano", no de la IA. Este que es un tema delicado tomando en cuenta algunas olas recientes de conflictos y violencia entre países: Ucrania y Rusia, Israel, Irán y Palestina.

Una declaración que llamó la atención fue la del profesor de informática de la Universidad de California en Berkeley, Stuart Russell, indicando que "pueden cumplir si no desarrollan IA hasta que sepan cómo hacerla segura". Y es una realidad, no olvidemos lo que se comentó sobre DeepSeek y la IA que puede resultar insegura para los usuarios más principiantes.

Puedes estar tranquilo: la Inteligencia Artificial no es un riesgo para la humanidad

Veremos si esta iniciativa logra llegar a los oídos de los políticos y gobernantes más influyentes del mundo. ¿La IA debe ser regulada por los gobiernos o por funcionarios encargados y con conocimientos del tema? Sin duda será un tema de interés público en el que pondremos más atención, seguramente marcado por el avance que tenga en años venideros.