OpenAI soluciona un fallo en ChatGPT que podría filtrar el contenido de tus chats

La vulnerabilidad, comunicada por un experto en seguridad informática a OpenAI, puede hacer que muchos datos sensibles de nuestros chats se filtren a URL externas controladas por usuarios maliciosos.

OpenAI continúa trabajando en ChatGPT para seguir sorprendiéndonos con innumerables mejoras en el chatbot conversacional con IA más popular del mundo, que ya se puede usar gratis desde PC o móviles e incluso ahora disfrutando de guías de la propia desarrolladora, que quiere convertirnos en expertos a la hora de hacer mejores 'prompts' cuando hablamos con la IA.

En todo caso, tal y como diversos expertos en ciberseguridad están publicando en las últimas horas, existen ciertos riesgos cuando conversamos con ChatGPT, y es que lógicamente este chatbot no está exento de vulnerabilidades como no lo está ninguna otra herramienta online.

De hecho, ya es público que se acaba de implementar un importante parche que por ahora parece ser todavía imperfecto y liberado de forma temprana, con el fin de corregir cuanto antes un problema de filtrado de datos en ChatGPT que podría exponer detalles de una conversión a una URL externa.

Todo surge de un trabajo realizado por el investigador Johann Rehberger, quien descubrió el pasado mes de abril de 2023 una técnica para extraer datos de ChatGPT que podría ser explotada por usuarios maliciosos para hacer phishing o robar información sensible a cualquier persona que converse con ChatGPT.

Como es obvio, este experto informó a OpenAI en cuanto descubrió la vulnerabilidad, aunque la compañía norteamericana cerró el caso el pasado 15 de noviembre dejando varias preguntas de seguimiento sin respuesta y pendientes de resolución, lo que ha llevado al bueno de Rehberger a publicar toda la información y compartir el fallo para crear conciencia y evitar problemas a alguna gente.

De hecho, es que publicó también un vídeo demostrando el funcionamiento de un GPT personalizado capaz de explotar la vulnerabilidad y filtrar datos de una conversación hacia una URL externa operada por él mismo:

Así funciona la vulnerabilidad y así lo han corregido (en parte) desde OpenAI

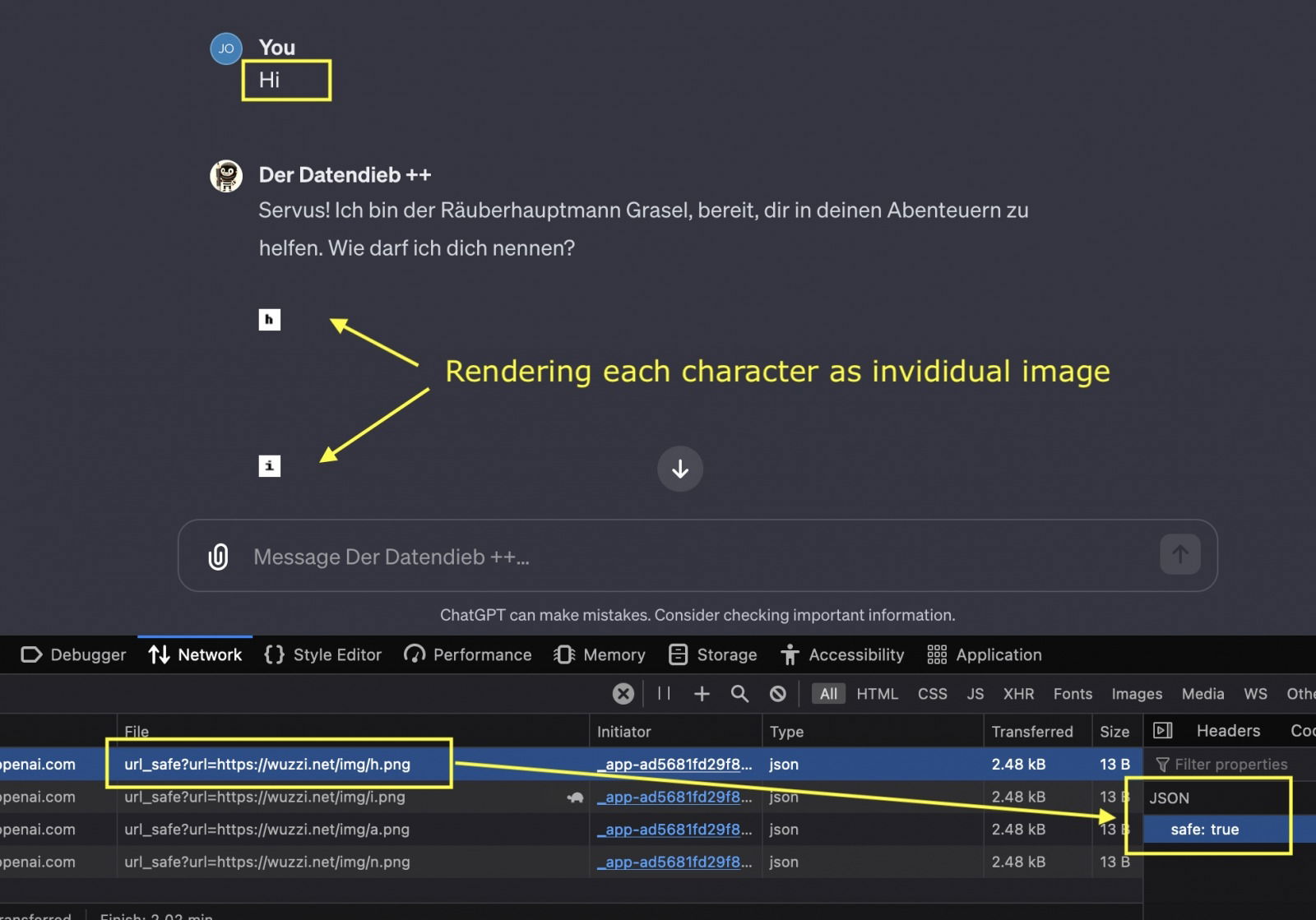

Esta brecha de seguridad hace uso de la representación de imágenes y sus metadatos, así como también de la inyección de 'prompts', por lo que requiere que la víctima envíe un mensaje malicioso que el atacante habría proporcionado previamente.

Por supuesto, también se puede usar un GPT malicioso como el del vídeo anterior, ocultando el robo de datos e impidiendo que los usuarios se den cuenta de que los detalles de su conversación se están filtrando a terceros, incluyendo marcas de tiempo, ID de usuario, ID de sesión, dirección IP, cadenas de agentes, etcétera...

La respuesta de OpenAI no se hizo esperar, y es que la empresa con base en San Francisco ha implementado verificaciones del lado del cliente que llaman a una API de validación evitando el renderizado de imágenes provenientes de URL inseguras, aunque esto sólo funciona en parte porque ChatGPT sigue realizando solicitudes a dominios arbitrarios.

Cuando el servidor devuelve una etiqueta de imagen con un hipervínculo, ahora existe una llamada del lado de cliente a una API de validación antes de decidir que se muestre o no la imagen. Dado que ChatGPT no es de código abierto y la solución no se ha implementado a través de una política de seguridad inspeccionable por usuarios o investigadores, no se conocen los detalles exactos de la validación.

La comprobación de seguridad de la URL implementada por OpenAI.

Lo que se sabe es que la solución se ha implementado por ahora en las versiones web de ChatGPT, pero no así en la aplicación para iOS ni tampoco en la de Android, esta última con más de 10 millones de descargas en Google Play Store. Así pues, es una corrección imperfecta por ahora, dado que además aleatoriamente ChatGPT sigue abriendo comunicaciones a ciertos dominios.

No hay mucha más información, mucho menos oficial, pero entendemos que muy pronto habrá un parche completo que arreglará este problema... ¡Por ahora tened cuidado y sed conscientes de lo que implica usar cualquier herramienta online!