El futuro del audio: realidad aumentada, sonido espacial y experiencias inmersivas

El sonido ya no se limita a izquierda y derecha: empieza a funcionar como espacio, con dirección, distancia y presencia

Durante décadas dábamos por hecho que el estéreo era el final del camino. Izquierda, derecha, un poco de reverb y ya. Pero el mercado se ha movido. El audio inmersivo, incluyendo sonido 3D y formatos espaciales, está creciendo de forma sostenida: la industria pasa de unos 7.500 millones de dólares en 2023 a más de 32.000 millones proyectados para 2033. No es una moda, es un cambio de paradigma en cómo entendemos la escucha.

Lo importante no es la tecnología en sí, sino la sensación. Ahora el sonido tiene dirección, distancia y altura. No se trata solo de escuchar una canción, sino de sentir dónde está cada elemento: la batería detrás, la voz enfrente, un sintetizador que se mueve sobre tu cabeza. Se está intentando replicar cómo oímos en la vida real, no cómo hemos aprendido a escuchar a través de altavoces.

Y el punto clave es este: la escucha ya no es algo genérico. Lo que viene es audio que se adapta a la persona, no al revés. Cada cráneo, cada pabellón auditivo y cada contexto de uso influye en cómo percibimos el sonido. La tecnología está empezando a asumirlo, y ahí es donde se está librando la verdadera batalla. El futuro no es “sonido mejor”. Es sonido que te reconoce.

Audio espacial y sonido 3D

El audio 3D es lo que sitúa nuestra percepción del sonido de una fuente

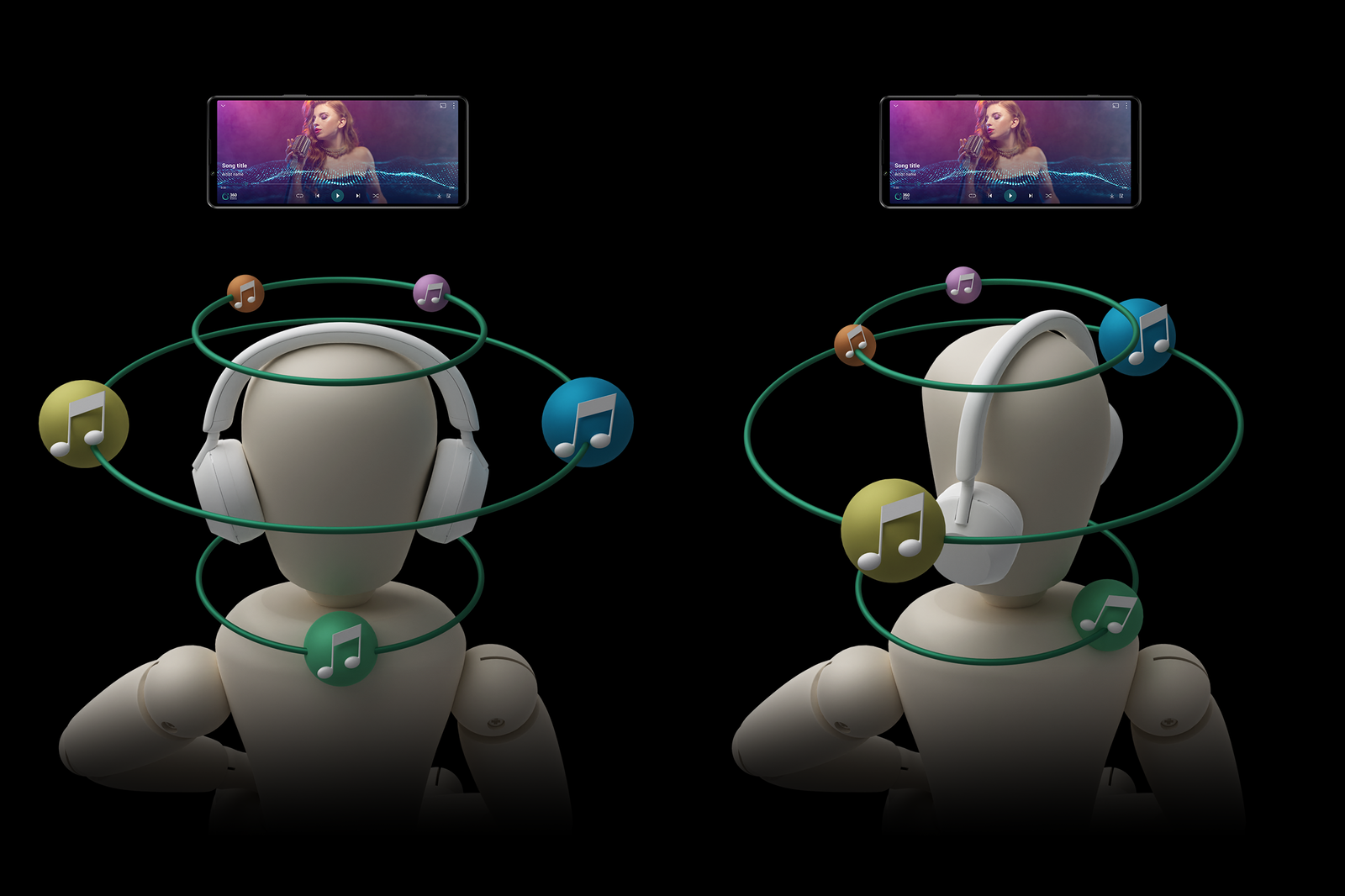

El estéreo era una simplificación: dos puntos fijos que intentaban representar todo un espacio. Funcionaba porque no había alternativa. El audio espacial parte de otra premisa: el sonido ocupa un volumen. Existen fuentes delante, detrás, arriba, cerca o lejos. No es una “mejora” del estéreo, es un cambio de modelo. Dolby Atmos, Sony 360 Reality Audio o MPEG-H no buscan sonar más grande, sino más real.

La diferencia no se explica bien en fichas técnicas, sino al escucharlo. Esto es algo que pudimos comprobar de primera mano en nuestra visita al showroom de Bowers & Wilkins España: una batería puede sentirse a dos metros detrás de ti, una voz puede mantenerse fija en el centro aunque gires la cabeza, un sintetizador puede ascender por encima de tu campo auditivo sin subir el volumen. Es la misma música, pero con la misma lógica con la que percibimos el mundo: tiene tres dimensiones.

Su adopción empezó en el cine y los videojuegos, y ahora se está filtrando a música en streaming y dispositivos cotidianos. Apple lo empujó hacia el mainstream, Sony lo integró en sus gamas altas, Bose lo aplica a modelos de uso diario. Y sí, también hay marcas como JBL que han incorporado sonido espacial en modelos como los Tour Pro 3 o los Live Beam 3. El concepto ya no es elitista, pero tampoco está completamente asentado.

La realidad es que aún estamos en transición. No todo el catálogo musical está mezclado en formato espacial y no todos los dispositivos interpretan igual la escena. Hay mezclas excelentes y mezclas convertidas automáticamente que suenan a artificio. Pero la dirección es clara: el estándar ya no será escuchar qué suena, sino dónde está sonando. El cambio cultural viene después, cuando la audiencia empiece a exigirlo sin darse cuenta.

Head tracking y posicionamiento dinámico

El head tracking de unos auriculares coloca los distintos sonidos en ellos en función de dónde se encuentra nuestra cabeza. No es tanto que el sonido se mueva con nosotros, sino nuestra percepción del mismo con respecto a su origen

Hay un detalle que delata si el audio espacial está bien hecho o no: girar la cabeza. Si el sonido se mueve contigo, es un efecto. Si el sonido se queda donde estaba, es un espacio. El head tracking no es un “extra tecnológico”, es lo que ancla la escena sonora en un lugar concreto. El oído reconoce esa estabilidad de inmediato porque así funciona en la vida real.

En videojuegos es donde más se nota. Localizar pasos en un pasillo, un disparo detrás de una esquina, un motor pasando a tu izquierda. La orientación deja de depender de intuición auditiva y se convierte en una lectura del entorno. En cine ocurre algo parecido: la habitación que estás viendo en pantalla se extiende más allá del marco. Y en música, cuando la mezcla acompaña, aparece una intimidad extraña: es como estar físicamente dentro del espacio donde está la voz.

No está todo resuelto. Algunos sistemas todavía exageran la espacialidad y terminan sonando a efecto envolvente artificial. Otros funcionan mejor solo con ciertos tipos de contenido. Y aún queda camino en ergonomía, latencia y calibración individual. Pero la dirección ya está marcada: el sonido deja de ser una pared y empieza a ser un lugar al que entras. Aquí es donde el audio deja de acompañar y empieza a rodearte.

Personalización y HRTF: el sonido que se adapta a la persona

No todos oímos igual. Parece obvio, pero se ha ignorado durante décadas. La forma de la oreja, el tamaño del canal auditivo, la densidad de la cabeza, incluso pequeños pliegues del cartílago cambian cómo percibimos dirección, distancia y timbre. Dos personas escuchan la misma canción con los mismos auriculares y no la reciben igual, porque no están interpretando el mismo espacio sonoro.

La HRTF es, en esencia, la huella acústica de cada individuo. No es una curva mágica ni una ecualización secreta. Es el mapa de cómo tu cuerpo modifica el sonido antes de que llegue al oído interno. El cerebro usa ese mapa para deducir dónde está cada fuente. Sin ese mapa, el audio espacial se vuelve una simulación genérica: puede impresionar al principio, pero dura poco; el oído se da cuenta de que algo no cuadra.

Durante mucho tiempo, obtener una HRTF personalizada no era viable. Se necesitaban cámaras anecoicas, altavoces calibrados, micrófonos dentro del canal auditivo y alguien que supiera interpretar los datos. Era trabajo de laboratorio, no algo que un usuario pudiera hacer en casa. Por eso el sonido espacial convivió tantos años con esa sensación de “casi”: estaba cerca de lo natural, pero aún sonaba prestado.

La diferencia ahora es que ya no hace falta un laboratorio. Un smartphone con buena cámara y un poco de software puede aproximar tu HRTF a partir de geometría: orejas, mandíbula, inclinación del cuello. No es perfecto, pero es suficiente para que el cerebro reconozca patrones que antes no estaban presentes. Es la puerta de entrada a que el audio deje de ser estándar y empiece a ser personal.

Y aquí está la clave real: sin un perfil propio, el audio inmersivo puede impresionar pero no engaña. Con un perfil propio, la escena sonora deja de sentirse “procesada” y pasa a sentirse natural. No suena más fuerte, ni más ancho, ni más “envolvente”. Simplemente ocurre donde tiene que ocurrir. No parece un truco. Parece presencia.

AR, VR y el sonido como espacio compartido

En la realidad mixta y en la realidad virtual el audio espacial es fundamental

En los entornos virtuales la vista puede engañar fácilmente, pero el oído no. Si una voz procede de un lugar que no coincide con la posición del interlocutor, la ilusión se rompe. Si el sonido no tiene profundidad o dirección, el cerebro lo interpreta como algo artificial. La presencia en AR y VR no se consigue con gráficos más nítidos, sino con coherencia sonora.

Cuando el audio está bien anclado en el espacio, cada elemento tiene una posición que se mantiene aunque te muevas. Una conversación se siente como conversación, no como audio flotando en estéreo. Una sala virtual parece sala porque el sonido rebota donde debería rebotar. El oído es el que define el volumen, la distancia y la densidad del lugar. La inmersión, en el fondo, es un acuerdo sensorial: si el sonido cuadra, todo lo demás entra.

Hoy existen experiencias donde esto ya funciona con solvencia: gaming competitivo, cine VR específico, algunos conciertos virtuales, reuniones 3D bien diseñadas. Pero también hay casos donde el audio espacial es solo un filtro más, un efecto de panoramización inflado. La diferencia entre una cosa y la otra está en si el entorno se siente habitable o solo espectacular. La espectacularidad pasa. La habitabilidad permanece.

Esto importa porque no se queda en videojuegos ni en mundos futuristas: llamadas de voz con ubicación espacial, colaboración remota donde se distingue quién habla desde dónde, clases y talleres donde el espacio sonoro estructura la atención. Cuando el sonido se organiza en torno a la posición, el entorno empieza a tener sentido. No es un truco. Es orientación.

Tecnologías complementarias

La vibración de los mandos al reproducirse ciertos sonidos en la pantalla es también un ejemplo de audio inmersivo

La inmersión no se sostiene solo con la espacialidad, hace falta cuerpo. La retroalimentación háptica no es una vibración puntual: es una forma de darle masa al sonido. Cuando un grave no solo se oye, sino que se siente, el cerebro lo interpreta como presencia física. No es efecto dramático, es información sensorial añadida. El sonido deja de ser algo que flota y pasa a ocupar espacio en tu escala corporal.

El audio de alta resolución tampoco va de “más calidad” o “más detalle”, va de aire. Cuando hay más información disponible entre los instrumentos, aparece la sensación de que la mezcla respira. Las voces se despegan del fondo, los planos se ordenan, el oído se relaja. Códecs como LDAC o transmisiones multipunto como Auracast no son nombres técnicos: son la posibilidad de que el sonido viaje sin deformarse en el trayecto —sin pérdidas ya es otro tema—.

No todo está terminado. Hay implementaciones hápticas que se sienten torpes, y hay mezclas Hi-Res que solo inflan los agudos sin aportar profundidad. El punto no es que todo esto sea perfecto ya, sino que todas estas tecnologías empujan en la misma dirección: que el sonido deje de ser algo que se recibe y pase a ser algo que ocurre. Lo inmersivo no es una estética, es una forma de relación. El sonido deja de estar “ahí”. Empieza a estar aquí.

Lo que queda después del efecto

Estamos en un momento en el que la tecnología del sonido está dejando de ser “característica” para convertirse en infraestructura sensorial. El audio inmersivo no llega como una mejora incremental, sino como una corrección histórica: durante décadas simplificamos la experiencia auditiva para adaptarla a los dispositivos, no al oído humano. Ahora el camino se está deshaciendo. Volvemos a la escucha como espacio, no como línea entre dos puntos.

La clave no está solo en los formatos ni en los algoritmos, sino en cómo se adapta cada sistema a cada persona. Sin personalización, el sonido espacial puede impresionar, pero no engaña. Con ella, aparece la sensación de ubicación, volumen real, distancia y profundidad. Lo inmersivo no es un efecto, es una correspondencia entre el cuerpo y el entorno sonoro. Cuando esa correspondencia se da, el cerebro deja de dudar. Y entonces, la tecnología desaparece.

Lo que viene ahora es más silencioso. No tanto nuevos nombres comerciales, sino una progresiva naturalización de todo esto. Cuando el sonido vuelva a sentirse natural, no hablaremos de audio espacial ni de perfiles, sólo escucharemos. El resto quedará en segundo plano, como sucede con casi todo lo que se asimila.